La boîte d’outils Statistiques spatiales fournit des outils efficaces pour quantifier les modèles spatiaux. À l’aide de l’outil Analyse de points chauds par exemple, vous pouvez poser des questions du type :

- Existent-ils des régions aux États-Unis où les gens meurent jeunes en nombre ?

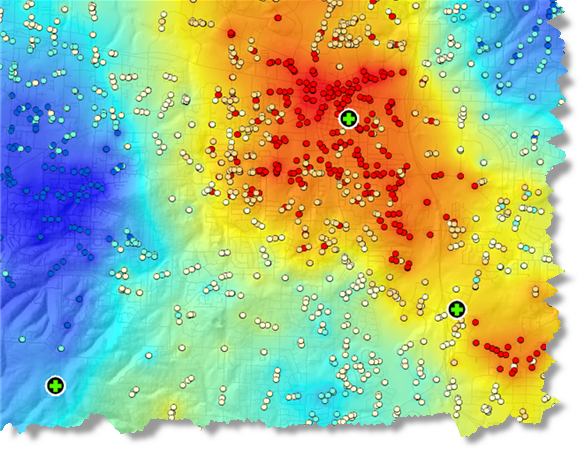

- Où sont localisés les points chauds pour la criminalité, les appels d'urgence (voir le graphique ci-dessous) ou les incendies ?

- Où trouve-t-on une proportion plus importante d'accidents de la route que prévu dans une ville ?

Chacune des questions ci-dessus porte sur la localisation (« Où ? ») La question logique suivante pour les types d'analyse ci-dessus consiste à savoir "pourquoi ?"

- Pourquoi certaines régions des États-Unis présentent-elles un fort taux de mortalité chez les jeunes ? Quelle peut en être la raison ?

- Pouvons-nous modéliser les caractéristiques des endroits qui connaissent un fort taux de criminalité, d'appels d'urgence ou d'incendies afin d'aider à réduire le nombre de ces incidents ?

- Quels sont les facteurs qui contribuent à une proportion plus importante que prévu d’accidents de la route ? Existe-t-il des stratégies ou des solutions susceptibles de réduire les accidents de la route dans la ville et/ou dans une zone particulièrement accidentogène ?

Ces outils sont notamment la régression Moindres carrés ordinaires et Régression pondérée géographiquement.

Relations spatiales

L’analyse de régression permet de modéliser, d’examiner et d’explorer les relations spatiales et peut contribuer à expliquer les facteurs sous-jacents aux modèles spatiaux observés. Vous voulez comprendre pourquoi les gens meurent jeunes en nombre dans certaines régions du pays ou connaître les facteurs qui contribuent à des taux anormalement élevés de diabète. En modélisant les relations spatiales, toutefois, l’analyse de régression peut également servir à des prévisions. La modélisation des facteurs qui contribuent aux taux d’obtention des diplômes, par exemple, vous permet d’établir des prévisions concernant les compétences et les ressources de la main-d’œuvre à venir. Vous pouvez également utiliser la régression pour prévoir les précipitations ou la qualité de l'air dans les cas où l'interpolation est insuffisante en raison de la rareté des appareils de mesure (par exemple, les pluviomètres sont souvent absents sur les crêtes des montagnes et dans les vallées).

La régression à l’aide des moindres carrés ordinaires fait partie des techniques de régression les plus connues. C’est également le véritable point de départ de toutes les analyses de régression spatiales. Elle offre un modèle global de la variable ou du processus que vous tentez de comprendre ou de prévoir (décès prématuré/précipitations). Cette analyse crée une équation de régression unique qui représente ce processus. La régression pondérée géographiquement est l’une des techniques de régression spatiale qui est de plus en plus utilisée en géographie et dans d’autres disciplines. Elle offre un modèle local de la variable ou du processus que vous tentez de comprendre ou de prévoir en ajustant une équation de régression à chaque entité du jeu de données. Lorsqu'elles sont utilisées correctement, ces méthodes offrent des statistiques puissantes et fiables permettant d'examiner et d'évaluer les relations linéaires.

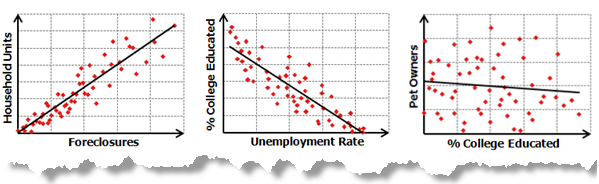

Les relations linéaires sont positives ou négatives. Si vous découvrez que le nombre de recherches et de sauvetages augmente avec la montée des températures diurnes, la relation est considérée comme positive. Il existe une corrélation positive. Pour exprimer cette relation positive, vous pouvez également dire que les recherches et les sauvetages diminuent avec la baisse des températures diurnes. À l’inverse, si vous découvrez que la criminalité diminue avec l’augmentation du nombre d’officiers de police qui patrouillent dans la zone, la relation est considérée comme négative. Vous pouvez également exprimer cette relation négative en indiquant que la criminalité augmente avec la réduction du nombre d’officiers de police. Le graphique ci-dessous illustre la relation positive et la relation négative, ainsi que l'absence de relation entre deux variables :

Les analyses de corrélation et leurs graphiques associés illustrés ci-dessus permettent de tester la force de la relation entre deux variables. Les analyses de régression, d'un autre côté, vont plus loin : elles tentent de démontrer dans quelle mesure une ou plusieurs variables peuvent promouvoir un changement positif ou négatif dans une autre variable.

Applications de l'analyse de régression

L'analyse de régression peut être utilisée dans un grand nombre d'applications :

- Modélisation des taux de maintien au lycée pour mieux comprendre les facteurs qui contribuent à maintenir les enfants à l'école.

- Modélisation des accidents de la circulation en tant que fonction de la vitesse, de l'état des routes, de la météo et autres pour informer les services de police de la route.

- Modélisation des pertes immobilières par incendie en tant que fonction de variables, telles que le degré d’implication des pompiers, le temps de réaction ou les valeurs immobilières. Si vous découvrez que le temps de réaction est le facteur clé, il peut être nécessaire de construire davantage de casernes de pompiers. Si vous découvrez que l'implication est le facteur clé, il peut être nécessaire d'augmenter l'équipement et le nombre de pompiers.

Vous pouvez faire appel à l'analyse de régression pour trois raisons principales :

- Pour modéliser certains phénomènes afin de mieux les comprendre et potentiellement exploiter ces connaissances en vue de modifier la réglementation ou de prendre des décisions sur les mesures qui s’imposent. L’objectif principal consiste à mesurer l’ampleur de l’impact des changements conjointement apportés à une ou plusieurs variables sur une autre variable. Exemple : comprendre les principales caractéristiques de l'habitat de certaines espèces d'oiseaux en danger (précipitations, sources de nourriture, végétation, prédateurs) afin d'aider à mettre en place une législation destinée à protéger ces espèces.

- Pour modéliser certains phénomènes qui prévoient des valeurs dans d’autres lieux ou à d’autres périodes. L’objectif principal est d’élaborer un modèle de prévision à la fois cohérent et précis. Exemple : en prenant la croissance démographique projetée et les conditions météorologiques typiques, quelle sera la demande en électricité l'année prochaine ?

- Vous pouvez également utiliser les analyses de régression pour explorer différentes hypothèses. Supposons que vous modélisiez la criminalité résidentielle afin de mieux la comprendre et dans l’espoir de mettre en œuvre une stratégie susceptible de l’enrayer. Lorsque vous débutez votre analyse, vous avez certainement envie d'examiner certaines questions ou hypothèses :

- La « théorie de la fenêtre brisée » indique que la dégradation des biens publics (graffitis, structures endommagées, etc.) induit d’autres délits. Existera-t-il une relation positive entre le vandalisme et les cambriolages résidentiels ?

- Existe-il une relation entre l'usage interdit de la drogue et les cambriolages (les personnes droguées sont-elles susceptibles de voler pour financer leur addiction) ?

- Les cambrioleurs sont-ils des prédateurs ? Les quartiers résidentiels sont-ils plus exposés, en particulier les ménages de personnes âgées ou les foyers dont le chef de famille est une femme ?

- Les personnes qui vivent dans un quartier riche ou pauvre courent-elles plus de risques d'être cambriolées ?

Termes et concepts de l'analyse de régression

Il est impossible d'aborder l'analyse de régression sans connaître certains termes et concepts de base propres aux statistiques de régression :

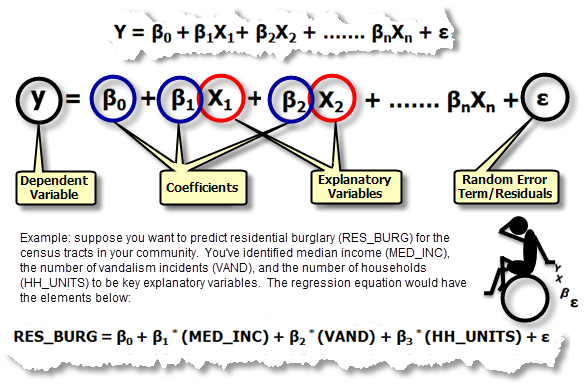

Équation de régression : il s’agit de la formule mathématique appliquée aux variables explicatives en vue de prévoir de façon optimale la variable dépendante que vous essayez de modéliser. Malheureusement pour les géoscientifiques qui considèrent x et y comme des coordonnées, la notation dans les équations de régression est toujours y pour la variable dépendante et toujours X pour les variables indépendantes ou explicatives. Chaque variable indépendante est associée à un coefficient de régression qui décrit la force et le signe de la relation de cette variable avec la variable dépendante. Une équation de régression peut ressembler à ceci (y est la variable dépendante, les X sont les variables explicatives et les β sont les coefficients de régression. Chacun de ces composants de l'équation de régression est expliqué plus loin) :

- Variable dépendante (y) : il s’agit de la variable représentant le processus que vous essayez de prévoir ou comprendre (cambriolages résidentiels, saisies ou précipitation). Dans l’équation de régression, elle figure à gauche du signe égal. Même si vous pouvez utiliser la régression pour prévoir la variable dépendante, commencez toujours par un ensemble de valeurs y connues et utilisez-les pour élaborer (ou pour calibrer) le modèle de régression. Les valeurs y connues sont souvent désignées sous le nom de valeurs observées.

- Variables indépendantes/explicatives (X) : il s’agit des variables utilisées pour modéliser ou pour prévoir les valeurs de la variable dépendante. Dans l’équation de régression, elles figurent à droite du signe égal et sont souvent appelées variables explicatives. La variable dépendante est une fonction des variables explicatives. Si vous souhaitez prévoir les achats annuels d'un point de vente proposé, vous pouvez intégrer à votre modèle des variables explicatives représentant le nombre de clients potentiels, la distance par rapport à la concurrence, la visibilité du point de vente et des modèles d'achats locaux, par exemple.

- Coefficients de régression (β) : les coefficients sont calculés par l’outil de régression. Il s’agit de valeurs, une pour chaque variable explicative, qui représentent la force et le type de relation entre la variable explicative et la variable dépendante. Supposons que vous modélisiez la fréquence des incendies en tant que fonction du rayonnement solaire, de la végétation, des précipitations et de l’exposition. Vous pouvez anticiper une relation positive entre la fréquence des incendies et le rayonnement solaire (en d’autres termes, plus il y a de soleil, plus les incendies sont fréquents). Lorsque la relation est positive, le signe du coefficient associé est également positif. Vous pouvez anticiper une relation négative entre la fréquence des incendies et les précipitations (en d’autres termes, les lieux présentant plus de pluie sont moins touchés par les incendies). Les coefficients correspondant à des relations négatives sont négatifs. Lorsque la relation est forte, le coefficient est relativement important (par rapport aux unités de la variable explicative à laquelle il est associé). Les relations faibles sont associées à des coefficients proches de zéro. β0 est l’ordonnée à l’origine de la régression.Il représente la valeur attendue pour la variable dépendante si toutes les variables indépendantes (explicatives) sont égales à zéro.

Valeurs p : la plupart des méthodes de régression réalisent un test statistique afin de calculer une probabilité, nommée valeur p, pour les coefficients associés à chaque variable indépendante. L’hypothèse nulle pour ce test statistique indique qu’un coefficient n’est pas significativement différent de zéro (en d’autres termes, le coefficient est en réalité égal à zéro et la variable explicative associée n’apporte rien à votre modèle). Les valeurs p faibles reflètent des probabilités moindres et suggèrent que le coefficient est en réalité important pour votre modèle avec une valeur qui est significativement différente de zéro (en d’autres termes, une valeur p faible indique que le coefficient n’est pas égal à zéro). Cela signifie qu’un coefficient avec une valeur p de 0,01, par exemple, est statistiquement significatif à un niveau de confiance de 99 pour cent. La variable associée est un outil de prévision efficace. Des variables avec des coefficients proches de zéro n'aident pas à prévoir ni à modéliser la variable dépendante. Elles sont presque toujours supprimées de l'équation de régression (à moins qu'il n'existe des raisons théoriques importantes de les garder).

R2/R-carré : R-carré multiple et R-carré ajusté sont des statistiques qui découlent de l’équation de régression pour mesurer les performances du modèle. La valeur de R-carré est comprise entre 0 et 100 %. Si votre modèle correspond parfaitement aux valeurs observées de la variable dépendante, la valeur R-carré est de 1,0 (et vous avez sans aucun doute commis une erreur ; peut-être avez-vous utilisé une forme de y pour prévoir y). Plus probablement, vous verrez des valeurs R-carré de 0,49, par exemple, que vous pouvez interpréter en disant « Ce modèle explique 49 pour cent de la variation dans la variable dépendante ». Pour comprendre la portée de la valeur R-carré, créez un diagramme à barres présentant à la fois les valeurs y estimées et observées, triées par les valeurs estimées. Portez votre attention sur la superposition. Ce graphique offre une représentation visuelle de la manière dont les valeurs prévues du modèle expliquent la variation dans les valeurs observées de la variable dépendante. Illustration. La valeur R-carré ajusté est toujours légèrement inférieure à la valeur R-carré multiple, car elle reflète la complexité du modèle (le nombre de variables) dans sa relation aux données. Par conséquent, la valeur R carré ajustée constitue une mesure plus précise de la performance du modèle.

Valeurs résiduelles : il s’agit de la portion non expliquée de la variable dépendante, représentée dans l’équation de régression comme le terme d’erreur aléatoire ε. Illustration. Les valeurs connues pour la variable dépendante sont utilisées pour créer et calibrer le modèle de régression. À l’aide de valeurs connues pour la variable dépendante (y) et de valeurs connues pour toutes les variables explicatives (les X), l’outil de régression élabore une équation destinée à prévoir aussi bien que possible les valeurs y connues. Les valeurs prévues correspondent toutefois rarement exactement aux valeurs observées. La différence entre les valeurs y observées et les valeurs y prévues s’appelle les valeurs résiduelles. L’importance des valeurs résiduelles d’une équation de régression permet de mesurer l’adéquation du modèle. Des valeurs résiduelles élevées indiquent un faible ajustement au modèle.

La création d’un modèle de régression est un processus itératif qui implique la recherche de variables indépendantes efficaces pour expliquer la variable dépendante que vous essayez de modéliser ou de comprendre, l’exécution de l’outil de régression pour identifier les variables qui constituent des outils de prévision efficaces, puis la suppression et/ou l’ajout répétitif de variables jusqu’à ce que vous trouviez le meilleur modèle de régression possible. Même si le processus de création du modèle revêt souvent un caractère d’exploration, il ne doit jamais constituer une « recherche à l’aveuglette ». Vous devez identifier les variables explicatives candidates en faisant appel à la théorie, aux experts sur le terrain et au bon sens. Vous devez être capable d'indiquer et de justifier la relation attendue entre chaque variable explicative candidate et la variable dépendante avant de lancer l'analyse et vous devez questionner les modèles lorsque ces relations ne correspondent pas.

Remarque :

Si vous n’avez encore jamais utilisé l’analyse de régression, vous pouvez télécharger le didacticiel concernant l’analyse de régression et suivre les étapes 1 à 5.

Problèmes concernant l'analyse de régression

La régression à l’aide des moindres carrés ordinaires est une méthode simple, qui s’appuie sur une théorie bien développée et qui compte un certain nombre de diagnostics efficaces qui contribuent à l’interprétation et à la résolution des problèmes éventuels. La méthode des moindres carrés ordinaires n’est toutefois fiable et efficace que si vos données et le modèle de régression répondent à toutes les suppositions requises de manière inhérente par cette méthode (voir le tableau ci-dessous). Les données spatiales enfreignent souvent les suppositions et prérequis de la régression à l'aide des moindres carrés ordinaires. Il est par conséquent important d'utiliser les outils de régression avec des outils de diagnostic capables d'évaluer si la régression est une méthode appropriée à votre analyse, étant donné la structure des données et le modèle en cours d'implémentation.

Corruption des modèles de régression

Une spécification erronée constitue une infraction sérieuse pour de nombreux modèles de régression. Un modèle incorrectement spécifié est un modèle incomplet, auquel il manque des variables explicatives importantes, et qui ne peut par conséquent pas représenter ce que vous essayez de modéliser ou de prévoir (la variable dépendante, y). En d’autres termes, le modèle de régression ne raconte pas toute l’histoire. La spécification erronée est évidente lorsque vous voyez une auto-corrélation spatiale statistiquement significative dans vos valeurs résiduelles de régression ou, pour le dire autrement, lorsque vous remarquez que les sur et sous-prévisions (valeurs résiduelles) de votre modèle ont tendance à s’agréger spatialement (les sur-prévisions s’agrègent dans certaines parties de la zone d’étude et les sous-prévisions s’agrègent dans d’autres). Les valeurs résiduelles de régression cartographique ou les coefficients associés à l’analyse Régression pondérée géographiquement permettent souvent d’identifier les problèmes. L’exécution de l’outil Analyse de points chauds sur les valeurs résiduelles de régression peut également révéler différents régimes spatiaux pouvant être modélisés dans la méthode des moindres carrés ordinaires avec des variables régionales ou pouvant être résolus à l’aide de la méthode de régression pondérée géographiquement. Supposons que lorsque vous cartographiez vos valeurs résiduelles de régression, vous constatez que le modèle émet toujours des surestimations dans les zones montagneuses et des sous-estimations dans les vallées. Vous allez probablement en conclure qu’une variable d’altitude manque à votre modèle. Il peut toutefois arriver que les variables manquantes soient trop complexes à modéliser ou impossibles à quantifier ou trop difficiles à mesurer. Dans ce cas, vous pouvez faire appel à la régression pondérée géographiquement (GWR) ou à une autre méthode de régression spatiale pour améliorer la spécification du modèle.

Le tableau suivant répertorie les problèmes courants liés aux modèles de régression, ainsi que les outils disponibles dans ArcGIS pour les résoudre ;

Problèmes de régression courants, conséquences et solutions

Variables explicatives omises (spécification erronée). | Lorsque des variables explicatives clés sont absentes d'un modèle de régression, les coefficients et leurs valeurs de p associées ne sont pas fiables. | Cartographiez et examinez les valeurs résiduelles de la méthode des moindres carrés ordinaires (OLS) et les coefficients de la régression pondérée géographiquement (GWR) ou exécutez l’outil Analyse de points chauds sur les valeurs résiduelles de régression par la méthode des moindres carrés ordinaires (OLS) pour générer des indices sur les variables manquantes possibles. |

Relations non linéaires. Illustration. | La méthode des moindres carrés ordinaires et la régression pondérée géographiquement sont des méthodes linéaires. Si la relation linéaire entre une des variables explicatives et la variable dépendante est non linéaire, le modèle résultant sera peu performant. | Soyez particulièrement attentif aux relations qui concernent la variable dépendante. La curvilinéarité peut souvent être résolue par la transformation des variables. Illustration. Vous pouvez également utiliser une méthode de régression non linéaire. |

Points aberrants de données. Illustration. | Les points aberrants influents peuvent écarter les relations de régression modélisées de leur meilleur ajustement, en représentant de manière incorrecte les coefficients de régression. | Corrigez ou supprimez les points aberrants s’ils représentent des erreurs. Lorsque les points aberrants ont des valeurs correctes/valides, ils ne peuvent/doivent pas être supprimés. Exécutez la régression avec et sans les points aberrants pour voir dans quelle mesure ils affectent vos résultats. |

Non-stationnarité. Vous pouvez découvrir qu’une variable de revenu, par exemple, dispose d’un pouvoir explicatif fort dans la région A, mais est insignifiante ou même inverse les signes dans la région B. Illustration. | Si les relations entre vos variables dépendantes et explicatives sont incohérentes dans votre zone d'étude, les erreurs standard calculées seront artificiellement élevées. | L’outil Moindres carrés ordinaires de ArcGIS recherche automatiquement les problèmes associés à la non-stationnarité (variation régionale) et calcule les valeurs des erreurs standard inhérentes. Illustration. Lorsque la probabilité associée au test de Koenker est faible (< 0,05 par exemple), vous faites face à une variable régionale statistiquement significative et vous devez consulter les probabilités inhérentes pour déterminer si une variable explicative est statistiquement significative ou non. Vous pouvez améliorer les résultats du modèle à l’aide de l’outil Régression pondérée géographiquement. |

Multicolinéarité. Une combinaison de variables explicatives est redondante. Illustration. | La multicolinéarité entraîne un surnombre de types d'incorrections et un modèle instable/non fiable. | L’outil Moindres carrés ordinaires de ArcGIS vérifie automatiquement la redondance. Une valeur VIF calculée est affectée à chaque variable explicative. Lorsque cette valeur est élevée (> 7,5 par exemple), la redondance constitue un problème et les variables concernées doivent être supprimées du modèle ou modifiées en créant une variable d’interaction ou en augmentant la taille d’échantillon. Illustration. |

Variance incohérente dans les valeurs résiduelles. Il peut arriver que les prévisions du modèle soient correctes pour les petites valeurs de la variable dépendante, mais qu’elles perdent de leur fiabilité pour les valeurs élevées. Illustration. | Lorsque les prévisions du modèle sont médiocres pour une certaine plage de valeurs, les résultats peuvent être déformés. | L’outil Moindres carrés ordinaires de ArcGIS recherche automatiquement la variance incohérente des valeurs résiduelles (nommée hétéroscédasticité) et calcule les erreurs standard qui sont inhérentes à ce problème. Lorsque la probabilité associée au test de Koenker est faible (< 0,05 par exemple), vous devez consulter les probabilités inhérentes pour déterminer si une variable explicative est statistiquement significative ou non. Illustration. |

Valeurs résiduelles auto-corrélées spatialement. Illustration. | Lorsque le modèle génère une agrégation spatiale des sur et sous-prévisions, cela produit un surnombre de types d'incorrections et rend le modèle non fiable. | Exécutez l’outil Auto-corrélation spatiale sur les valeurs résiduelles pour garantir qu’elles ne présentent pas d’agrégation spatiale statistiquement significative. L’auto-corrélation spatiale statistiquement significative indique presque toujours une spécification erronée (une variable clé est absente du modèle). Illustration. |

Déformation de la distribution normale. Illustration. | Lorsque les valeurs résiduelles du modèle de régression ne sont pas correctement distribuées avec une moyenne de zéro, les valeurs de p associées aux coefficients ne sont pas fiables. | L’outil Moindres carrés ordinaires de ArcGIS cherche automatiquement à savoir si les valeurs résiduelles sont normalement distribuées. Lorsque la statistique Jarque-Bera est significative (< 0,05 par exemple), il est probable que la spécification de votre modèle soit incorrecte (une variable clé est absente du modèle) ou que certaines des relations que vous modélisez soient non linéaires. Examinez la carte résiduelle en sortie, ainsi que les cartes de coefficient de régression pondérée géographiquement, pour voir si cet exercice met en exergue les variables clés manquantes de l’analyse. |

Il est important de rechercher chacun des problèmes répertoriés ci-dessus. Les résultats risquent d'être complètement incorrects (différence de 180 degrés) si les problèmes ci-dessus ne sont pas pris en compte.

Remarque :

Si vous n’avez encore jamais utilisé l’analyse de régression, vous pouvez télécharger et suivre le didacticiel concernant l’analyse de régression.

Régression spatiale

Les données spatiales présentent deux propriétés qui rendent difficile (mais pas impossible) le respect des suppositions et prérequis des méthodes statistiques traditionnelles (non spatiales), telles que la régression OLS :

- Les entités géographiques sont le plus souvent auto-corrélées spatialement. Cela signifie que les entités proches les unes des autres ont tendance à se ressembler davantage que les entités les plus éloignées. Ce phénomène engendre un surnombre de types d'incorrections pour les méthodes de régression traditionnelles (non spatiales).

- La géographie est importante, et les processus les plus importants pour ce que vous modélisez sont souvent non stationnaires. Ces processus se comportent différemment dans les différentes parties de la zone d’étude. Cette caractéristique des données spatiales est désignée sous le nom de variation régionale ou non stationnarité.

De vraies méthodes de régression spatiale ont été développées dans le but de gérer ces deux caractéristiques des données spatiales, et même pour intégrer ces qualités spéciales des données spatiales en vue d’améliorer leur capacité à modéliser des relations spatiales. Certaines méthodes de régression spatiale traitent efficacement la première caractéristique (auto-corrélation spatiale), tandis que d’autres traitent efficacement la seconde (non-stationnarité). Pour le moment, aucune méthode de régression spatiale n’est efficace pour les deux caractéristiques. Pour un modèle de régression pondérée géographiquement correctement spécifié toutefois, l’auto-corrélation spatiale ne pose généralement aucun problème.

Auto-corrélation spatiale

Il semble qu’il existe une grande différence entre la manière dont un statisticien traditionnel considère l’auto-corrélation spatiale et la manière dont un statisticien spatial considère l’auto-corrélation spatiale. Le statisticien traditionnel la voit comme une chose à éviter, qui doit être supprimée des données (via le rééchantillonnage, par exemple), car l’auto-corrélation enfreint les suppositions sous-jacentes de nombreuses méthodes statistiques traditionnelles (non spatiales). Pour le géographe ou l’analyste SIG en revanche, l’auto-corrélation spatiale est la preuve que des processus spatiaux sous-jacents importants sont à l’œuvre. Elle constitue une part intégrante des données. La suppression de l’espace retire les données de leur contexte spatial ; cela revient à n’entendre qu’une seule partie de l’histoire. Les processus spatiaux et les relations spatiales qui sont évidents dans les données sont d’un intérêt de premier ordre et l’une des raisons pour lesquelles les utilisateurs de GIS sont si enthousiastes à l’encontre de l’analyse des données spatiales. Pour éviter un surnombre de types d’incorrections dans votre modèle, cependant, vous devez identifier l’ensemble complet des variables explicatives qui captureront efficacement la structure spatiale inhérente dans votre variable dépendante. Si vous ne parvenez pas à identifier toutes ces variables, une auto-corrélation spatiale statistiquement significative apparaîtra probablement dans les valeurs résiduelles du modèle. Malheureusement, vous ne pouvez pas vous fier à vos résultats de régression tant que ce problème n’est pas résolu. Utilisez l’outil Auto-corrélation spatiale pour rechercher une auto-corrélation spatiale statistiquement significative dans vos valeurs résiduelles de régression.

Trois stratégies au moins permettent de gérer l'auto-corrélation spatiale dans les valeurs résiduelles du modèle de régression :

- Rééchantillonnez jusqu’à ce que les variables en entrée ne présentent plus d’auto-corrélation spatiale statistiquement significative. Même si cela ne garantit pas qu’aucun problème d’auto-corrélation spatiale ne subsiste dans l’analyse, ces problèmes sont beaucoup moins susceptibles de se produire lorsque l’auto-corrélation est supprimée des variables explicatives et dépendantes. Il s'agit de l'approche du statisticien traditionnel face à l'auto-corrélation spatiale. Elle ne convient que si l'auto-corrélation spatiale est le résultat de la redondance des données (structure d'échantillonnage trop petite).

- Isolez les composants spatiaux et les composants non spatiaux de chaque variable en entrée à l’aide d’une méthode de régression de filtrage spatial. L’espace est supprimé de chaque variable, mais est ensuite réintégré dans le modèle de régression sous forme de nouvelle variable pour prendre en compte les effets spatiaux/la structure spatiale. ArcGIS ne propose actuellement pas de méthodes de régression de filtrage spatial.

- Incorporez l’auto-corrélation dans le modèle de régression à l’aide des méthodes de régression d’économétrie spatiale. Les méthodes de régression d'économétrie spatiale seront ajoutées à ArcGIS dans une prochaine version.

Variation régionale

Les modèles globaux, tels que la régression des moindres carrés ordinaires (OLS), créent des équations qui décrivent de manière optimale les relations générales des données dans une zone d’étude. Lorsque ces relations sont cohérentes dans toute la zone d’étude, l’équation de régression OLS modélise parfaitement ces relations. Lorsque ces relations ont des comportements différents dans les différentes parties de la zone d’étude, toutefois, l’équation de régression s’apparente davantage à une moyenne de l’ensemble des relations présentes. En outre, lorsque ces relations représentent deux extrêmes, la moyenne globale ne permet pas de modéliser convenablement les extrêmes. Lorsque vos variables explicatives présentent des relations non stationnaires (variation régionale), les modèles globaux ont tendance à s’éclipser sauf si des méthodes fiables sont utilisées pour calculer les résultats de régression. Dans l’idéal, vous serez en mesure d’identifier un ensemble complet de variables explicatives pour capturer la variable régionale inhérente à votre variable dépendante. Si vous ne parvenez toutefois pas à identifier toutes ces variables spatiales, vous remarquerez à nouveau une auto-corrélation spatiale statistiquement significative dans les valeurs résiduelles de votre modèle et/ou des valeurs R-carré plus faibles que prévu. Malheureusement, vous ne pouvez pas vous fier à vos résultats de régression tant que ce problème n'est pas résolu.

Vous pouvez gérer la variation régionale dans les modèles de régression OLS de quatre manières au moins :

- Incluez une variable dans le modèle qui explique la variation régionale. Si vous voyez que votre modèle émet toujours des surestimations dans le nord et des sous-estimations dans le sud, par exemple, ajoutez une variable régionale définie sur 1 pour les entités situées au nord et sur 0 pour les entités situées au sud.

- Utilisez des méthodes qui intègrent la variation régionale dans le modèle de régression, par exemple la régression pondérée géographiquement.

- Examinez les erreurs standard de régression et les probabilités pour déterminer si les coefficients des variables sont statistiquement significatifs. La régression pondérée géographiquement est toujours recommandée.

- Redéfinissez/Réduisez la taille de la zone d'étude afin que les processus qu'elle contient soient tous stationnaires (afin qu'ils ne présentent plus de variation régionale).

Ressources supplémentaires

Pour plus d'informations sur l'utilisation des outils de régression, reportez-vous aux rubriques suivantes :

Vous avez un commentaire à formuler concernant cette rubrique ?