Analiza regresji jest techniką analityczną służącą do obliczania szacunkowej zależności między zmienną zależną, a jedną lub kilkoma zmiennymi opisującymi. Posługując się analizą regresji, można modelować zależność między wybranymi zmiennymi, a także przewidywać wartości w oparciu o określony model.

Analiza regresji — informacje ogólne

Analiza regresji stosuje wybraną metodę szacowania, zmienną zależną i jedną lub większą liczbę zmiennych opisujących w celu utworzenia równania służącego do oszacowania wartości zmiennej zależnej.

Model regresji obejmuje takie dane wynikowe, jak R2 i wartości p, dostarczając informacje na temat dokładności szacowania zmiennej zależnej za pomocą określonego modelu.

W analizie regresji do analizowania zależności i sprawdzania założeń mogą być również używane diagramy, takie jak macierze diagramów punktowych, histogramy i diagramy punktów.

Analiza regresji może być wykorzystana do rozwiązania następujących zagadnień:

- Określanie, które zmienne opisujące są powiązane ze zmienną zależną.

- Rozpoznawanie zależności między zmienną zależną, a zmiennymi opisującymi.

- Przewidywanie nieznanych wartości zmiennej zależnej.

Przykłady

Analityk niewielkiej sieci handlowej bada wydajność różnych lokalizacji sklepów. Chce on znaleźć przyczynę tego, że w niektórych sklepach wartość sprzedaży jest niższa od spodziewanej. Tworzy model regresji obejmujący zmienne opisujące, takie jak średni wiek i dochody w pobliskich dzielnicach, a także odległość do centrów handlowych i przystanków komunikacji publicznej, w celu określenia zmiennych mających wpływ na sprzedaż.

Analityk Departamentu Edukacji bada wpływ programu organizowania posiłków śniadaniowych w szkołach. Tworzy on model regresji wyników edukacyjnych, którym może być np. wskaźnik liczby osób kończących szkołę, używając zmiennych opisujących, takich jak wielkość klasy, dochód gospodarstwa domowego, budżet szkolny przypadający na osobę i procent uczniów jedzących codziennie śniadanie. Równanie utworzone w modelu może służyć do określenia względnego wpływu każdej ze zmiennych na wyniki edukacyjne.

Analityk instytucji pozarządowej bada globalną emisję gazów cieplarnianych. Tworzy on model regresji dla najnowszych wartości emisji w poszczególnych krajach, używając takich zmiennych opisujących, jak produkt krajowy brutto (PKB), liczba ludności, produkcja energii elektrycznej z wykorzystaniem paliw kopalnych i używanie pojazdów. Utworzony model może następnie posłużyć do przewidywania wielkości emisji gazów cieplarnianych w przyszłości z użyciem prognozowanej wartości PKB i liczby ludności.

Metoda najmniejszych kwadratów

Analiza regresji w aplikacji ArcGIS Insights jest modelowana przy użyciu metody najmniejszych kwadratów (OLS).

Metoda OLS jest rodzajem wielokrotnej regresji liniowej, co oznacza, że zależność między zmiennymi zależnymi, a zmiennymi niezależnymi musi być modelowana przez dopasowanie równania liniowego do obserwowanych danych.

Model najmniejszych kwadratów stosuje następujące równanie:

yi=β0+β1x1+β2x2+...+βnxn+εgdzie:

- yi=obserwowana wartość zmiennej zależnej w punkcie i

- β0=przecięcie z osią y (wartość stała)

- βn=współczynnik regresji lub nachylenia dla zmiennej objaśniającej N w punkcie i

- xn=wartość zmiennej N w punkcie i

- ε=błąd równania regresji

Założenia

Każda metoda regresji przyjmuje określone założenia, które muszą być spełnione, aby równanie można było uznać za wiarygodne. Założenia metody najmniejszych kwadratów należy weryfikować przy tworzeniu modelu regresji.

Przy stosowaniu metody najmniejszych kwadratów należy sprawdzać, czy spełnione są poniższe założenia:

- Model musi być liniowy.

- Dane muszą być próbkowane w sposób losowy.

- Zmienne objaśniające nie mogą być współliniowe.

- Zmienne objaśniające muszą mieć pomijalny błąd pomiaru.

- Błędy mają oczekiwaną sumę równą zero.

- Błędy mają wariancję jednorodną.

- Błędy mają rozkład normalny.

- Sąsiadujące błędy nie mogą wykazywać autokorelacji.

Model musi być liniowy

Regresja najmniejszych kwadratów może być używana tylko do tworzenia modelu liniowego. Liniowość między zmienną zależną, a zmiennymi opisującymi można sprawdzić za pomocą diagramu punktowego. Macierz diagramów punktowych nadaje się do sprawdzania wszystkich zmiennych, jeśli tylko liczba wszystkich zmiennych nie przekracza pięciu.

Dane muszą być próbkowane w sposób losowy

Dane wykorzystywane w analizie regresji powinny być próbkowane w taki sposób, że próbki nie są zależne od żadnego zewnętrznego czynnika. Próbkowanie losowe można sprawdzić, używając błędów z modelu regresji. Błędy, które są danymi wynikowymi pochodzącymi z modelu regresji, nie powinny wykazywać korelacji przy wykreślaniu ich względem zmiennych opisujących na diagramie punktowym lub macierzy diagramów punktowych.

Zmienne opisujące nie mogą być współliniowe

Współliniowość oznacza liniową zależność między zmiennymi opisującymi, która jest źródłem nadmiarowości w modelu. W niektórych przypadkach może powstać model posiadający cechę współliniowości. Jednak, gdy zachodzi podejrzenie, że jedna ze współliniowych zmiennych jest zależna od innej, warto rozważyć usunięcie tej zmiennej z modelu. Współliniowość można sprawdzić za pomocą diagramu punktowego lub macierzy diagramów punktowych zmiennych opisujących.

Zmienne opisujące muszą mieć pomijalny błąd pomiaru

Model regresji jest na tyle dokładny, na ile dokładne są dane wejściowe. Jeśli zmienne opisujące mają duży margines błędu, model nie może być uważany za dokładny. Podczas wykonywania analizy regresji istotną rzeczą jest korzystanie tylko z zestawów danych pochodzących z wiarygodnych źródeł, aby mieć pewność, że błąd będzie pomijalny.

Błędy mają oczekiwaną sumę równą zero

Błędy są różnicą między wartościami obserwowanymi i szacowanymi w analizie regresji. Wartości obserwowane mieszczące się powyżej krzywej regresji będą miały dodatnią wartość błędu, a wartości obserwowane znajdujące się poniżej krzywej regresji — wartość ujemną. Krzywa regresji powinna leżeć pośrodku punktów danych, wówczas suma błędów będzie równa zero. Suma pól może być obliczona w tabeli podsumowania.

Błędy mają wariancję jednorodną

Wariancja powinna być taka sama dla wszystkich błędów. To założenie można sprawdzić przy użyciu diagramu punktowego błędów (oś y) oraz wartości szacowanych (oś x). Wynikowy diagram punktowy powinien wyglądać jak poziome pasmo losowo rozmieszczonych punktów na całym diagramie.

Błędy mają rozkład normalny

Rozkład normalny, nazywany także krzywą dzwonową, jest rozkładem występującym naturalnie, gdy częstotliwość zdarzeń jest bardzo bliska wartości średniej, a ulega odkształceniu, gdy od wartości średniej się oddala. Rozkład normalny jest często stosowany w analizie statystycznej jako hipoteza zerowa. Błędy muszą mieć rozkład normalny, aby zapewnić, że linia najlepszego dopasowania przebiega optymalnie, pośrodku obserwowanych punktów danych i nie przechyla się bardziej w kierunku niektórych z nich. To założenie można sprawdzić poprzez utworzenie histogramu z błędami. Istnieje możliwość nałożenia krzywej rozkładu normalnego, a na odwrocie karty histogramu zostaną wyświetlone miary asymetrii i kurtozy.

Sąsiadujące błędy nie mogą wykazywać autokorelacji

To założenie odnosi się do danych uporządkowanych czasowo. Jeśli dane są uporządkowane czasowo, każdy punkt danych musi być niezależny od punktu go poprzedzającego oraz następującego po nim. Z tego powodu ważne jest, by przy wykonywaniu analizy regresji dane uporządkowane czasowo miały prawidłową kolejność. To założenie można sprawdzić za pomocą testu Durbina-Watsona.

Test Durbina-Watsona daje miarę autokorelacji błędów w modelu regresji. Test Durbina-Watsona stosuje skalę wartości od 0 do 4, gdzie wartości od 0 do 2 wskazują na autokorelację dodatnią, wartość 2 wskazuje brak autokorelacji, a wartości od 2 do 4 wskazują autokorelację ujemną. Dlatego wartości bliskie 2 są pożądane ze względu na spełnienie warunku braku autokorelacji błędów. Ogólnie wartości z przedziału 1,5-2,5 są uznawane za akceptowalne, natomiast wartości mniejsze niż 1,5 lub większe niż 2,5 wskazują, że model nie pasuje do założenia braku autokorelacji.

Poprawność modelu

Dokładność równania regresji jest ważną częścią analizy regresji. We wszystkich modelach występuje pewien poziom błędu, ale rozumienie danych statystycznych jest pomocne w ocenie, czy dany model nadaje się do zastosowania przy określonej analizie, czy też niezbędne będą pewne korekty.

Istnieją dwie techniki umożliwiające ustalenie, czy model regresji jest poprawny: analiza eksploracyjna i analiza potwierdzająca.

Analiza eksploracyjna

Analiza eksploracyjna jest metodą analizowania danych wykorzystującą różnorodne techniki wizualne i statystyczne. Podczas kursu analizy eksploracyjnej będą testowane założenia regresji OLS i porównywane efektywności różnych zmiennych objaśniających. Analiza eksploracyjna pozwala porównać efektywność i dokładność różnych modeli, ale nie odpowiada na pytanie, czy dany model powinien być używany czy nie. Analizę eksploracyjną należy przeprowadzać przed analizą potwierdzającą dla każdego modelu regresji i wykonywać kolejne jej iteracje w celu porównania poszczególnych modeli.

W ramach analizy eksploracyjnej można używać następujących diagramów i statystyk:

- Diagram punktowy i macierz diagramów punktowych

- Histogram i rozkład normalny

- Równanie regresji i prognozowanie nowych obserwacji

- Współczynnik determinacji, R2 i skorygowany współczynnik R2

- Resztkowy błąd standardowy

- Diagram punktów

Analizę eksploracyjną należy rozpocząć podczas wybierania zmiennych objaśniających, a przed utworzeniem modelu regresji. Ponieważ OLS to metoda regresji liniowej, jednym z głównych założeń jest to, że model musi być liniowy. Diagramu punktowego lub macierzy diagramów punktowych można używać do oceniania liniowości między zmiennymi zależnymi i zmiennymi objaśniającymi. W ramach macierzy diagramów punktowych można wyświetlić do czterech zmiennych objaśniających wraz ze zmiennymi zależnymi, co czyni ją ważnym narzędziem służącym do porównywania wszystkich zmiennych w dużej skali. Na jednym diagramie punktowym można wyświetlić tylko dwie zmienne: jedną zmienną zależną i jedną zmienną niezależną lub objaśniającą. Diagram punktowy zawierający zmienną zależną i jedną zmienną objaśniającą umożliwia przeprowadzenie dokładniejszej oceny relacji występującej między tymi zmiennymi. Liniowość można przetestować przed utworzeniem modelu regresji, dzięki czemu można ustalić, które zmienne objaśniające pozwolą utworzyć akceptowalny model.

Po utworzeniu modelu regresji dostępnych jest kilka wyników statystycznych, w tym równanie regresji, wartość R2 i test Durbina-Watsona. Po utworzeniu modelu regresji należy użyć wyników i niezbędnych diagramów oraz tabel w celu przetestowania pozostałych założeń regresji OLS. Jeśli model jest zgodny z założeniami, można kontynuować analizę eksploracyjną.

Równanie regresji zapewnia cenne informacje o wpływie poszczególnych zmiennych objaśniających na prognozowane wartości, w tym współczynnik regresji dla każdej zmiennej objaśniającej. Wartości nachylenia można porównywać w celu ustalenia względnego wpływu poszczególnych zmiennych objaśniających na zmienną zależną. Im bardziej wartość nachylenia różni się od zera (w stronę wartości dodatnich lub ujemnych), tym większy jest wpływ. Równania regresji można także używać do prognozowania wartości zmiennej zależnej, wprowadzając wartości poszczególnych zmiennych objaśniających.

Współczynnik determinacji oznaczany jako R2 określa dokładność modelowania rzeczywistych punktów danych przez równanie regresji. Wartość współczynnika R2 jest liczbą z przedziału od 0 do 1, gdzie wartości bliższe 1 wskazują większą dokładność modelu. Wartość współczynnika R2 równa 1 oznacza model doskonały, bardzo mało prawdopodobny w rzeczywistych sytuacjach, biorąc pod uwagę złożoność współzależności między różnymi czynnikami i nieznanymi zmiennymi. Dlatego należy się starać utworzyć model o możliwie najwyższej wartości współczynnika R2, chociaż nie zawsze będzie to wartość bliska 1.

Przy wykonywaniu analizy regresji istnieje ryzyko utworzenia modelu o akceptowalnej wartości współczynnika R2 w wyniku dodania zmiennych opisujących, które mogą jednak prowadzić do lepszego dopasowania w oparciu wyłącznie na prawdopodobieństwie. Wartość skorygowanego współczynnika R2, która także mieści się w przedziale od 0 do 1, uwzględnia jeszcze dodatkowe zmienne opisujące, zmniejszając rolę prawdopodobieństwa przy obliczeniach. Skorygowany współczynnik R2 powinien być wykorzystywany w modelach używających dużej liczby zmiennych opisujących lub przy porównywaniu modeli o różnej liczbie zmiennych opisujących.

Resztkowy błąd standardowy mierzy dokładność, z jaką model regresji może prognozować wartości przy zastosowaniu nowych danych. Mniejsze wartości wskazują bardziej dokładny model. Dlatego gdy porównywanych jest wiele modeli, model o najmniejszej wartości jest tym, który minimalizuje resztkowy błąd standardowy.

Diagramów punktowych można używać do analizowania zmiennych objaśniających pod kątem zależności, takich jak klastry i wartości odstające, które mogą wpływać na dokładność modelu.

Analiza potwierdzająca

Analiza potwierdzająca to proces testowania modelu względem hipotezy zerowej. W analizie regresji hipoteza zerowa zakłada, że nie ma relacji między zmienną zależną i zmiennymi objaśniającymi. Model bez relacji ma wartości nachylenia wynoszące 0. Jeśli elementy analizy potwierdzającej są statystycznie istotne, można odrzucić hipotezę zerową (innymi słowy istotność statystyczna wskazuje, że istnieje relacja między zmienną zależną i zmiennymi objaśniającymi).

Do ustalania istotności w analizie potwierdzającej używane są następujące wyniki statystyczne:

- Statystyka F i powiązana z nią wartość p

- Statystyka t i powiązane z nią wartości p

- Przedziały ufności

Statystyka F to statystyka globalna zwracana przez test F. Wskazuje ona zdolność prognozowania modelu regresji, sprawdzając, czy wszystkie współczynniki regresji w modelu są w sposób istotny różne od 0. Test F analizuje łączny wpływ zmiennych objaśniających, nie testuje natomiast poszczególnych zmiennych objaśniających. Ze statystyką F jest powiązana wartość p, która wskazuje prawdopodobieństwo tego, że relacje występujące w danych są przypadkowe. Ponieważ wartości p bazują na prawdopodobieństwach, należą do przedziału od 0,0 do 1,0. Niska wartość p, wynosząca zwykle 0,05 lub mniej, jest wymagana, aby stwierdzić, że relacje występujące w modelu są prawdziwe (czyli nie są przypadkowe) i odrzucić hipotezę zerową. W tym przypadku prawdopodobieństwo, że relacje występujące w modelu są przypadkowe, wynosi 0,05 (lub 1 do 20). Natomiast prawdopodobieństwo, że relacje występujące w modelu są prawdziwe, wynosi 0,95 (lub 19 do 20).

Statystyka t jest statystyką lokalną zwracaną przez test t, która wskazuje zdolność prognozowania każdej zmiennej objaśniającej indywidualnie. Podobnie jak test F, test t sprawdza, czy współczynniki regresji w modelu są w istotny sposób różne od zera. Jednak ponieważ test t jest przeprowadzany dla każdej zmiennej objaśniającej, model zwróci wartości statystyki t dla każdej zmiennej objaśniającej, a nie jedną wartość dla całego modelu. Z każdą statystyką t jest powiązana wartość p, która wskazuje istotność zmiennej objaśniającej. Podobnie jak wartości p testu F, wartości p każdego testu t powinny wynosić 0,05 lub mniej, aby można było odrzucić hipotezę zerową. Jeśli zmienna objaśniająca ma wartość p większą niż 0,05, należy odrzucić tę zmienną i utworzyć nowy model, nawet jeśli globalna wartość p była znacząca.

Przedziały ufności pozwalają wyświetlić współczynnik regresji dla każdej zmiennej objaśniającej oraz powiązane przedziały ufności (90, 95 i 99 procent). Dlatego przedziałów ufności można używać wraz z wartościami p z testów t do oceniania hipotezy zerowej poszczególnych zmiennych objaśniających. Współczynniki regresji nie mogą być równe 0, jeśli hipoteza zerowa ma być odrzucona, a dany model ma być nadal używany. Dlatego dla każdej zmiennej objaśniającej współczynnik regresji i powiązane przedziały ufności nie powinny nakładać się na wartość 0. Jeśli przedział ufności wynoszący 99 lub 95 procent dla danej zmiennej objaśniającej nakłada się na wartość 0, odrzucenie hipotezy zerowej na podstawie danej zmiennej objaśniającej zakończyło się niepowodzeniem. Dołączenie takiej zmiennej do modelu może mieć wpływ na jego ogólną istotność. Jeśli tylko przedział ufności wynoszący 90 procent nakłada się na wartość 0, można dołączyć zmienną objaśniającą do modelu, jednak pod warunkiem, że inne statystyki globalne są znaczące. Najlepiej, gdy przedziały ufności wszystkich zmiennych objaśniających są dalekie od wartości 0.

Inne wyniki

Inne wyniki, takie jak szacowane wartości i błędy, także są ważne w przypadku testowania założeń regresji OLS. W tej sekcji zostaną przedstawione dodatkowe informacje o tym, jak obliczane są te wartości.

Szacowane wartości

Szacowane wartości są obliczane przy użyciu równania regresji i wartości poszczególnych zmiennych objaśniających. Najlepiej, gdy szacowane wartości są takie same jak wartości obserwowane (czyli rzeczywiste wartości zmiennej zależnej).

Szacowane wartości są używane wraz z wartościami obserwowanymi do obliczania błędów.

Błędy

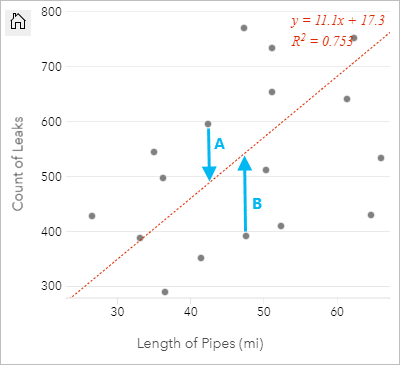

Wartości błędów w analizie regresji są różnicami między wartościami obserwowanymi w zestawie danych, a szacowanymi wartościami obliczonymi za pomocą równania regresji.

Błędy A i B dla powyższej zależności można obliczyć w następujący sposób:

błędyA = obserwowaneA - szacowaneA błędyA = 595 - 487,62 błędyA = 107,38błędyB = obserwowaneB - szacowaneB błędyB = 392 - 527,27 błędyB = -135,27Błędy mogą posłużyć do obliczenia dokładności równania regresji oraz do sprawdzenia niektórych założeń.