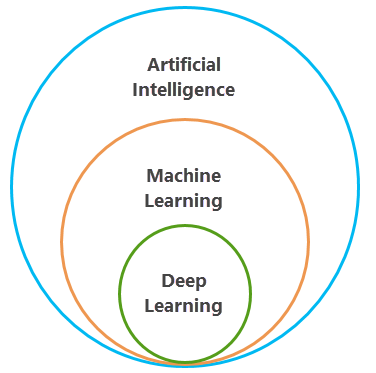

Les outils d’apprentissage automatique sont un composant clé de l’analyse spatiale SIG depuis des décennies. L’apprentissage automatique dans ArcGIS permet de classifier des images, d’enrichir des données par agrégation ou de modéliser des relations spatiales. L’apprentissage automatique est une branche de l’intelligence artificielle dans laquelle des données structurées sont traitées par un algorithme pour résoudre un problème. Dans les données structurées traditionnelles, une personne étiquette les données, comme les images de chats et de chiens, afin de permettre aux algorithmes de comprendre les caractéristiques spécifiques de chaque type d’animal et d’identifier ces animaux sur les autres images.

L’apprentissage profond est un sous-jeu de l’apprentissage automatique qui utilise plusieurs couches d’algorithmes sous la forme de réseaux neuronaux. Les données en entrée sont analysées via différentes couches du réseau, chaque couche définissant des entités et modèles spécifiques dans les données. Par exemple, si vous souhaitez identifier des entités telles que des bâtiments et des routes, le modèle de Deep Learning peut être entraîné avec des images de différents bâtiments et routes, en traitant les images via les couches du réseau neuronal, puis en recherchant les identifiants requis pour classer un bâtiment ou une route.

Esri a développé des outils et des processus pour tirer parti des dernières innovations de Deep Learning, et ainsi traiter certains aspects difficiles en matière d’applications SIG et de télédétection. La vision par ordinateur, ou la capacité qu’ont les ordinateurs à développer une compréhension à partir de vidéos ou d’images numériques, est un domaine qui s’est éloigné des algorithmes d’apprentissage automatique traditionnels au profit des méthodes d’apprentissage profond. Avant d’appliquer le Deep Learning aux images dans AllSource, il est important d’en comprendre les différentes applications pour la vision par ordinateur.

Applications de l’apprentissage profond pour la vision par ordinateur

De nombreuses tâches de vision par ordinateur peuvent s’accomplir avec les réseaux neuronaux de l’apprentissage profond. Esri a développé des outils qui vous permettent d’effectuer une classification d’images, une détection d’objets, une segmentation sémantique et une segmentation d’instances. Toutes ces tâches de vision par ordinateur sont décrites ci-dessous, chacune avec un exemple de télédétection et un exemple de vision par ordinateur plus général.

Classification des images

La classification d’images implique l’attribution d’une étiquette ou d’une classe à une image numérique. Par exemple, l’image de drone sur la gauche pourrait porter l’étiquette Foule et la photo numérique sur la droite pourrait s’appeler Chat. Ce type de classification se nomme également classification d’objets ou reconnaissance d’images et peut servir dans le domaine des SIG à classer les entités d’une image.

Détection d’objets

La détection d’objets consiste à localiser des entités dans une image. Par exemple, dans l’image de télédétection ci-dessous, le réseau neuronal a trouvé la position d’un avion. Dans un cas de vision par ordinateur plus général, un modèle peut être en capacité de détecter la localisation de différents animaux. Ce processus implique généralement le dessin d’une zone d’emprise autour des entités d’intérêt. Il peut servir dans les SIG pour localiser des entités spécifiques dans des images satellite, aériennes ou de drone et pour tracer ces entités sur une carte.

Segmentation sémantique

La segmentation sémantique se produit lorsque chaque pixel dans une image est classé comme appartenant à une classe. Par exemple, dans l’image de gauche ci-dessous, les pixels de route sont classés séparément des autres pixels. Sur la droite, les pixels qui constituent un chat sur une photo sont classés en tant que chat, tandis que les autres pixels de l’image appartiennent à d’autres classes. Dans le domaine des SIG, ce procédé est connu sous le nom de classification de pixels, de segmentation d’images ou de classification d’images. Il est souvent utilisé pour créer des cartes de classification de l’utilisation du sol.

Segmentation d’instances

La segmentation d’instances est une méthode de détection d’objets plus précise dans laquelle la limite de chaque instance d’objet est dessinée. Par exemple, dans l’image de gauche ci-dessous, les toitures sont détectées, y compris le contour précis de leur forme. Sur la droite, les voitures sont détectées, et vous pouvez distinguer clairement leur forme. Ce type d’application d’apprentissage profond également connu sous le nom de segmentation d’objets.

Segmentation panoptique

La segmentation panoptique associe la segmentation sémantique et la segmentation d’instances. Dans l’image d’exemple ci-dessous, tous les pixels sont classifiés et chaque objet, comme une voiture, correspond à un objet unique.

Conversion d’image

La conversion d’image consiste à transposer une image d’un style ou d’une représentation possible de la scène à un ou une autre, comme la réduction du bruit ou la super-résolution. Par exemple, l’image de gauche ci-dessous représente l’image basse résolution d’origine, et l’image de droite représente la même image après application d’un modèle de super-résolution. Ce type d’application de Deep Learning est également connu sous le nom de conversion image à image.

Détection de changement

En Deep Learning, les tâches de détection de changement permettent de détecter les changements opérés dans les entités d’intérêt entre deux dates et de générer une carte logique de ces changements. Par exemple, l’image de gauche ci-dessous montre un complexe résidentiel datant de cinq ans, l’image au centre montre le même complexe aujourd’hui, et l’image de droite montre la carte logique des changements sur laquelle les nouvelles habitations sont représentées en blanc.

Vous avez un commentaire à formuler concernant cette rubrique ?