决策树是一种有监督机器学习算法,由使用 AutoML 进行训练工具使用,并使用对某些问题的 true 或 false 答案对数据进行分类或回归。 最终结构的可视化形式是具有不同类型节点(根节点、内部节点和叶节点)的树。 根节点是决策树的起始位置,然后分支到内部节点和叶节点。 叶节点是最终的分类类别或实际值。 决策树很容易理解并且可以解释。

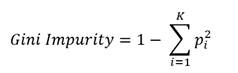

要构建决策树,首先需要指定将成为根节点的要素。 通常,不存在可以完美预测最终类别的单个要素;这称为杂质。 Gini、熵和信息增益等方法可用于测量这种杂质并确定要素对给定数据的分类程度。 选择杂质最少的要素作为任意层级的节点。 要计算具有数值的要素的 Gini 杂质,首先需要按升序对数据进行排序,然后计算相邻值的平均值。 然后,通过根据要素值是否小于或大于所选值以及该选择是否正确分类数据来排列数据点,计算每个所选平均值处的 Gini 杂质。 然后使用以下等式计算 Gini 杂质,其中 K 为分类类别数量,p 为这些类别的实例比例。

计算每个值下叶子的 Gini 杂质的加权平均值。 为该要素选择杂质最少的值。 对不同的要素重复该过程,以选择将成为节点的要素和值。 这个过程在每个深度级别的每个节点上迭代,直到完成所有数据的分类。 构建树后,要对数据点进行预测,请使用每个节点的条件沿树向下移动,以得出最终值或分类。 当使用决策树进行回归时,使用残差平方和或方差之和来衡量杂质而不是 Gini。 该方法的其余部分遵循类似的步骤。

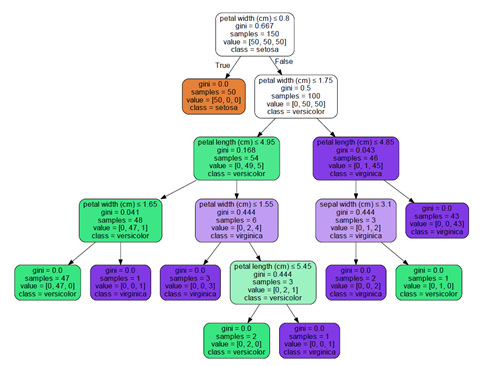

在以下示例中,显示了基于花瓣和花萼的宽度和高度对花朵进行分类的决策树:

其他资源

Quinlan, J. R. C4.5: Programs for Machine Learning. Morgan Kaufmann Publishers, 1993.