La plupart des tests statistiques commencent par identifier une hypothèse nulle. L'hypothèse nulle pour les outils d'analyse de modèles (Jeu d'outils Analyse de modèles et Jeu d'outils Appariement de grappes) est le caractère CSR (Complete Spatial Randomness, caractère aléatoire spatial complet), soit des entités elles-mêmes, soit des valeurs associées à ces entités. Les scores z et les valeurs p renvoyées par les outils d'analyse de modèles vous indiquent si vous pouvez ou non rejeter cette hypothèse nulle. Il vous arrivera souvent d'exécuter les outils d'analyse de modèles en espérant que le score z et la valeur p indiqueront que vous pouvez rejeter l'hypothèse nulle, car cela voudrait dire qu'à la place d'un modèle aléatoire, vos entités (ou les valeurs associées à vos entités) présentent une agrégation ou une dispersion statistiquement significative. Lorsque vous voyez une structure spatiale, par exemple une agrégation dans le paysage (ou dans vos données spatiales), vous voyez la preuve que des processus spatiaux sous-jacents sont à l'œuvre, et en tant que géographe ou analyste SIG, c'est souvent ce qui vous intéresse le plus.

La valeur p est une probabilité. Pour les outils d'analyse de modèle, c'est la probabilité que le modèle spatial observé a été créé par un processus aléatoire. Lorsque la valeur p est très basse, cela signifie qu'il est très improbable que le modèle spatial observé soit le résultat d'un processus aléatoire. Vous pouvez par conséquent rejeter l'hypothèse nulle. Vous pouvez vous demander : qu'entend-on par valeur basse exactement ? Bonne question. Consultez le tableau et l'explication ci-dessous.

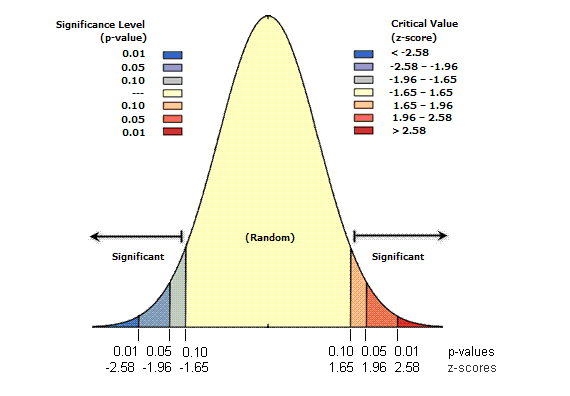

Les scores z sont des écarts types. Si, par exemple, un outil renvoie un score z de +2.5, cela signifie que le résultat est un écart type de 2,5. Les scores z et les valeurs p sont tous les deux associés à la répartition normale standard, comme illustré ci-dessous.

Les scores z très élevés ou très faibles (négatifs), associés à des valeurs p très basses, se trouvent aux extrémités de la répartition normale. Lorsque vous exécutez un outil d'analyse de modèles d'entité et qu'il produit des valeurs p basses et un score z très élevé ou très faible, cela indique qu'il est peu probable que le modèle spatial observé reflète le modèle aléatoire théorique représenté par votre hypothèse nulle (CSR).

Pour rejeter l'hypothèse nulle, vous devez évaluer de manière subjective le niveau de risque que vous êtes prêt à accepter au cas où vous vous tromperiez (si vous rejetez à tort l'hypothèse nulle). Vous devez par conséquent sélectionner un niveau de confiance avant d'exécuter les statistiques spatiales. Les niveaux de confiance standard sont de 90, 95 ou 99 pour cent. Un niveau de confiance de 99 pour cent est dans ce cas l'approche la plus modeste. Il indique que vous ne souhaitez pas rejeter l'hypothèse nulle, sauf si la probabilité que le modèle a été créé de manière aléatoire est très basse (probabilité inférieure à 1 pour cent).

Niveaux de confiance

Le tableau ci-dessous présente les valeurs p et les scores z critiques non corrigés pour différents niveaux de confiance.

Remarque :

les outils qui vous permettent d'appliquer la correction FDR (False Discovery Rate) utilisent des valeurs p critiques corrigées. Ces valeurs critiques sont égales ou inférieures à celles affichées dans le tableau ci-dessous.

| Score z (écarts types) | Valeur p (probabilité) | Niveau de confiance |

|---|---|---|

< -1,65 ou > +1,65 | < 0,10 | 90% |

< -1,96 ou > +1,96 | < 0,05 | 95% |

< -2,58 ou > +2,58 | < 0,01 | 99% |

Prenons un exemple. Les valeurs des scores z critiques avec un niveau de confiance de 95 pour cent sont des écarts types de -1,96 et +1,96. La valeur p non corrigée associée à un niveau de confiance de 95 pour cent est de 0,05. Si votre score z est compris entre -1,96 et +1,96, votre valeur p non corrigée est supérieure à 0,05 et vous ne pouvez pas rejeter votre hypothèse nulle, car le modèle présenté pourrait très bien être le résultat de processus spatiaux aléatoires. Si le score z n'est pas compris dans cet intervalle (par exemple, des écarts types de -2,5 ou de +5,4), le modèle spatial observé est probablement trop inhabituel pour être le fruit du hasard et la valeur p sera trop basse pour refléter cela. Dans ce cas, il est possible de rejeter l'hypothèse nulle et de tenter de découvrir la cause de la structure spatiale statistiquement significative dans vos données.

L'idée principale est que les valeurs qui se trouvent au centre de la répartition normale (des scores z, tels que 0,19 ou -1,2 par exemple) représentent le résultat attendu. Lorsque la valeur absolue du score z est importante et que les probabilités sont faibles (aux extrémités de la répartition normale), vous observez toutefois quelque chose d'inhabituel et de généralement très intéressant. Pour l'outil Analyse de points chauds par exemple, le terme "inhabituel" désigne un point chaud statistiquement significatif ou un point froid statistiquement significatif.

Correction FDR

Les outils d'analyse de modèles spatiaux locaux, notamment Hot Spot Analysis et Analyse de grappes et de valeurs aberrantes (Anselin Local Morans I) fournissent un paramètre booléen facultatif Appliquer la correction FDR (False Discovery Rate). Lorsque ce paramètre est sélectionné, la procédure FDR (False Discovery Rate) réduit potentiellement les seuils des valeurs p critiques affichées dans le tableau ci-dessus afin de tenir compte des tests multiples et de la dépendance spatiale. La réduction, si elle a lieu, est une fonction du nombre d'entités en entrée et de la structure de voisinage employée.

Les outils d'analyse de modèles spatiaux locaux prennent en compte chaque entité dans le contexte des entités voisines et déterminent si le modèle local (une entité cible et ses voisins) est statistiquement différent du modèle global (toutes les entités du jeu de données). Les résultats des scores z et des valeurs p associés à chaque entité déterminent si la différence est statistiquement significative ou non. L'approche analytique engendre des problèmes avec les tests multiples et la dépendance.

Tests multiples : avec un niveau de confiance de 95 pour cent, la théorie des probabilités nous apprend qu'il y a 5 chances sur 100 pour qu'un modèle spatial puisse apparaître de manière structurée (agrégé ou dispersé, par exemple) et pour qu'il soit associé à une valeur p statistiquement significative, alors qu'en fait, les processus spatiaux sous-jacents qui favorisent le modèle sont purement aléatoires. Dans ce cas, nous pourrions rejeter l'hypothèse nulle CSR à tort en raison des valeurs p statistiquement significatives. Cinq chances sur 100 paraît assez modeste jusqu'à ce que vous preniez en compte le fait que les statistiques spatiales locales effectuent un test pour chaque entité du jeu de données. Si le jeu de données comprend par exemple 10 000 entités, nous pouvons nous attendre à une proportion de 500 faux résultats.

Dépendance spatiale : les entités proches les unes des autres ont tendance à se ressembler et, la plupart du temps, les données spatiales présentent ce type de dépendance. Néanmoins, de nombreux tests statistiques ont besoin d'entités indépendantes. Pour les outils d'analyse de modèles locaux, cela s'explique par le fait que la dépendance spatiale peut augmenter artificiellement la signification statistique. La dépendance spatiale est exacerbée avec les outils d'analyse de modèles locaux, car chaque entité est évaluée dans le contexte de ses voisins et il est probable que les entités qui sont proches les unes des autres aient un grand nombre de voisins en commun. Ce chevauchement accentue la dépendance spatiale.

Trois approches au moins permettent de gérer les problèmes liés aux tests multiples et à la dépendance spatiale. La première approche consiste à ignorer le problème en se basant sur le fait que le test individuel effectué sur chaque entité du jeu de données doit être considéré de manière isolée. Avec cette approche toutefois, il est très probable que certains résultats statistiquement significatifs soient incorrects (les résultats semblent statistiquement significatifs alors qu'en fait, les processus spatiaux sous-jacents sont aléatoires). La deuxième approche consiste à appliquer une procédure de tests multiples classique, telle que les corrections Bonferroni ou Sidak. Ces méthodes sont toutefois généralement trop modestes. Bien qu'elles permettent de réduire considérablement le nombre de faux positifs, elles passent également à côté de résultats statistiquement significatifs lorsqu'il en existe. Une troisième approche consiste à appliquer la correction FDR qui estime le nombre de faux positifs pour un niveau de confiance donné et ajuste la valeur p critique en fonction. Pour cette méthode, les valeurs p statistiquement significatives sont classées des plus basses (les plus fortes) aux plus élevées (les plus faibles) et, d'après l'estimation des faux positifs, les plus faibles sont retirées de la liste. Les entités restantes dotées de valeurs p statistiquement significatives sont identifiées par les champs Gi_Bin ou COType dans la classe d'entités en sortie. Même si elle n'est pas parfaite, les tests empiriques montrent que cette méthode donne de meilleurs résultats que la méthode qui consiste à supposer que chaque test local est réalisé de manière isolée ou que l'application des méthodes traditionnelles, trop modestes, des tests multiples. La section Ressources supplémentaires apporte plus d'informations sur la correction FDR.

Hypothèse nulle et statistiques spatiales

Plusieurs outils statistiques de la boîte à outils Statistiques spatiales sont des techniques d'analyse de modèles spatiaux inférentielles, notamment Auto-corrélation spatiale (Global Morans I), Analyse de grappes et de valeurs aberrantes (Anselin Local Morans I) et Analyse de points chauds (Getis-Ord Gi*). Les statistiques inférentielles reposent sur la théorie des probabilités. Les probabilités permettent de mesurer le hasard et derrière les tests statistiques (que ce soit directement ou indirectement) se cachent des calculs de probabilité qui évaluent la part de hasard dans le résultat de votre analyse. En général, avec les statistiques traditionnelles (non spatiales), vous utilisez un échantillon aléatoire et tentez de déterminer la probabilité selon laquelle vos données d'exemple sont une bonne représentation (reflètent) de la population dans son ensemble. Vous pouvez par exemple vous demander : "Quelles sont les chances pour que les résultats de mon sondage (montrant que le candidat A va battre le candidat B avec une faible marge) reflètent les résultats de l'élection finale ?" Mais avec de nombreuses statistiques spatiales, y compris les statistiques d'auto-corrélation spatiale répertoriées ci-dessus, vous gérez très souvent toutes les données disponibles pour la zone d'étude (tous les délits, tous les cas de maladie, les attributs de tous les îlots de recensement, etc.). Lorsque vous calculez des statistiques pour la population totale, vous n'avez plus du tout une estimation. Vous avez un fait. Il n'est par conséquent plus approprié de parler de chances ou de probabilités. Dans ce cas, comment les outils d'analyse de modèles spatiaux, fréquemment appliqués à toutes les données de la zone d'étude, peuvent-ils légitimement rapporter des probabilités ? La réponse est la suivante : ils partent du principe, via l'hypothèse nulle, que les données font en réalité partie d'une population plus vaste. Examinons cela plus en détail.

Hypothèse nulle aléatoire : lorsque cela est opportun, les outils de la boîte à outils Statistiques spatiales utilisent l'hypothèse nulle aléatoire comme base des tests de signification statistique. L'hypothèse nulle aléatoire part du principe que le modèle spatial observé de vos données représente une des (n!) dispositions spatiales possibles. Si vous pouviez saisir des valeurs de vos données pour les rejeter dans les entités de votre zone d'étude, vous obtiendriez une disposition spatiale possible de ces valeurs. (Notez que la saisie des valeurs de vos données pour les rejeter de manière arbitraire est un exemple de processus spatial aléatoire). L'hypothèse nulle aléatoire indique que si vous pouviez réaliser cet exercice (les saisir et les rejeter) un nombre infini de fois, la plupart du temps, vous produiriez un modèle qui ne serait pas nettement différent du modèle observé (vos données réelles). De temps à autre, vous pourriez par accident rejeter toutes les valeurs les plus élevées dans le même coin de votre zone d'étude, mais la probabilité pour que cela arrive est faible. L'hypothèse nulle aléatoire indique que vos données sont l'une des innombrables versions possibles d'une structure totalement aléatoire. Les valeurs des données sont fixes, seule leur disposition spatiale peut varier.

Hypothèse nulle de normalisation : l'hypothèse nulle de normalisation, non implémentée dans la boîte à outils Statistiques spatiales, est une autre hypothèse nulle aléatoire connue. L'hypothèse nulle de normalisation part du principe que les valeurs observées découlent d'une population normalement répartie et infiniment plus vaste de valeurs au moyen d'un processus d'échantillonnage aléatoire. Avec un échantillon différent, vous pouvez obtenir différentes valeurs, mais vous vous attendez à ce que ces valeurs soient représentatives d'une plus vaste répartition. L'hypothèse nulle de normalisation indique que les valeurs représentent l'une des innombrables valeurs d'échantillons possibles. Si vous pouviez intégrer vos données observées dans une courbe normale et sélectionner de manière aléatoire des valeurs dans cette répartition afin de les lancer sur votre zone d'étude, la plupart du temps, vous produiriez un modèle et une répartition de valeurs qui ne seraient pas nettement différents du modèle et de la répartition observés (vos données réelles). L'hypothèse nulle de normalisation indique que vos données et leur disposition sont l'un des innombrables échantillons aléatoires possibles. Ni les valeurs des données, ni leur disposition spatiale ne sont fixes. L'hypothèse nulle de normalisation convient uniquement lorsque les valeurs des données sont normalement réparties.

Ressources supplémentaires :

- Ebdon, David. Statistics in Geography. Blackwell, 1985.

- Mitchell, Andy. The ESRI Guide to GIS Analysis, Volume 2. ESRI Press, 2005.

- Goodchild, M.F., Spatial Autocorrelation. Catmog 47, Geo Books, 1986

- Caldas de Castro, Marcia, and Burton H. Singer. "Controlling the False Discovery Rate: A New Application to Account for Multiple and Dependent Test in Local Statistics of Spatial Association." Geographical Analysis 38, pp 180-208, 2006.

Vous avez un commentaire à formuler concernant cette rubrique ?