| Étiquette | Explication | Type de données |

Type de prévision | Spécifie le mode d’opération utilisé. Vous pouvez exécuter l’outil pour entraîner un modèle dédié à l’évaluation des performances, à la prévision d'entités ou à la création d'une surface de prévision,

| String |

Entités d’entraînement en entrée | Classe d’entités contenant la valeur de paramètre Variable à prévoir et, le cas échéant, les variables d’entraînement explicatives issues des champs. | Feature Layer |

Variable à prévoir (Facultatif) | Variable du paramètre Entités d’entraînement en entrée contenant les valeurs à utiliser pour entraîner le modèle. Ce champ contient des valeurs (d’entraînement) connues de la variable qui sera utilisée pour réaliser des prévisions à des emplacements inconnus. | Field |

Traiter les variables comme catégorielles (Facultatif) | Indique si la valeur Variable à prévoir est une variable catégorielle.

| Boolean |

Variables d’entraînement explicatives (Facultatif) | Liste des champs qui représentent les variables explicatives utilisées pour prévoir la valeur ou la catégorie de la valeur Variable à prévoir. Cochez la case Categorical (Catégoriel) des variables qui représentent des classes ou des catégories (comme l’occupation du sol, la présence ou l'absence). | Value Table |

Entités de distance d’entraînement explicatives (Facultatif) | Couche d’entités contenant les entités de distance d’entraînement explicatives. Les variables explicatives sont automatiquement créées en calculant la distance entre les entités fournies et les valeurs Entités d’entraînement en entrée. Les distances sont calculées à partir de chacune des entités indiquées dans Entités d’entraînement en entrée vers les valeurs Entités de distance d’entraînement explicatives les plus proches. Si les valeurs Entités de distance d’entraînement explicatives en entrée sont des polygones ou des lignes, les attributs de distance sont calculés comme étant la distance entre les segments les plus proches de la paire d’entités. | Feature Layer |

Rasters d’entraînement explicatifs (Facultatif) | Les variables d’entraînement explicatives extraites de rasters. Les variables d’entraînement explicatives sont automatiquement créées en extrayant des valeurs de cellule raster. Pour chacune des entités du paramètre Entités d’entraînement en entrée, la valeur de la cellule raster est extraite à l’emplacement exact. Pour les rasters continus, la valeur de raster est extraite par la méthode de rééchantillonnage bilinéaire de raster. Pour les rasters catégoriels, la valeur de raster est extraite par la méthode d'affectation du voisin le plus proche. Cochez la case Categorical (Catégoriel) des rasters qui représentent des classes ou des catégories (comme l’occupation du sol, la présence ou l’absence). | Value Table |

Entités de prévision en entrée (Facultatif) | Classe d’entités qui représente les localisations où des prévisions sont réalisées. Cette classe d’entités doit également comporter toutes les variables explicatives fournies en tant que champs et correspondant aux champs utilisés issus des données d’entraînement. | Feature Layer |

Entités prévues en sortie (Facultatif) | La classe d’entités en sortie qui contient les résultats de la prévision. | Feature Class |

Surface de prévision en sortie (Facultatif) | Le raster en sortie qui contient les résultats de la prévision. La taille de cellule par défaut correspond à la taille de cellule maximale des entrées raster. Pour définir une taille de cellule différente, utilisez le paramètre d’environnement Taille de cellule. | Raster Dataset |

Apparier les variables explicatives (Facultatif) | Liste des valeurs Variables explicatives spécifiées dans le paramètre Entités d’entraînement en entrée à droite et de leurs champs correspondants dans le paramètre Entités de prévision en entrée à gauche. | Value Table |

Apparier les entités de distance (Facultatif) | Liste des valeurs Entités de distance explicatives spécifiées pour le paramètre Entités d’entraînement en entrée à droite et de leurs jeux d’entités correspondants dans le paramètre Entités de prévision en entrée à gauche. Si les valeurs Entités de distance explicatives qui sont utilisées pour l’entraînement se situent dans une zone d’étude ou une période différente, il est possible de fournir celles qui sont les plus adaptées au paramètre Entités de prévision en entrée. | Value Table |

Apparier les rasters explicatifs (Facultatif) | Liste des valeurs Rasters explicatifs spécifiées pour le paramètre Entités d’entraînement en entrée à droite et de leurs rasters correspondants dans le paramètre Entités de prévision en entrée ou Surface de prévision à créer à gauche. Si les valeurs Rasters explicatifs qui sont utilisées pour l’entraînement se situent dans une zone d’étude ou une période différente, il est possible de fournir celles qui sont les plus adaptées au paramètre Entités de prévision en entrée. | Value Table |

Entités entraînées en sortie (Facultatif) | Les variables explicatives utilisées pour l’entraînement (notamment les valeurs de raster échantillonnées et les calculs de distance), ainsi que le champ Variable à prévoir observé et les prévisions supplémentaires susceptibles d’être utilisées pour approfondir l’évaluation des performances du modèle entraîné. | Feature Class |

Table de l’importance des variables en sortie (Facultatif) | Table qui contient des informations décrivant l’importance de chaque variable explicative utilisée dans le modèle Les variables explicatives incluent les champs, les entités de distance et les rasters utilisés pour la création du modèle. Si le paramètre Type de modèle a pour valeur Gradient boosté, l’importance est mesurée par gain, pondération et couverture ; la table inclut alors ces champs. La sortie comprend un diagramme à barres si le paramètre Nombre d’exécutions pour la validation a pour valeur 1, ou une boîte à moustaches affichant l’importance des variables explicatives si la valeur est supérieure à 1. | Table |

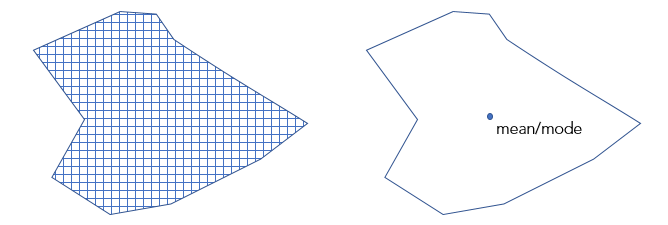

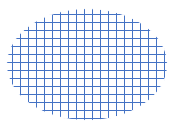

Convertir les polygones en résolution raster pour l'entraînement (Facultatif) | Détermine le mode de traitement des polygones pendant l’entraînement du modèle si les valeurs Entités d’entraînement en entrée sont des polygones avec une valeur catégorielle Variable à prévoir et que seules des valeurs Rasters d’entraînement explicatifs ont été spécifiées.

| Boolean |

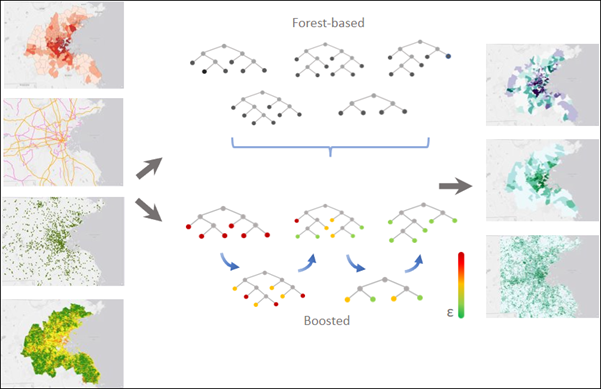

Nombre d’arbres (Facultatif) | Nombre d’arbres créés dans les modèles basés sur une forêt et à gradient boosté. La valeur par défaut est 100. Si le paramètre Type de modèle a pour valeur Basé sur une forêt, un nombre plus élevé d’arbres produisent généralement des prévisions de modèle plus précises, mais le temps de calcul est plus long. Si le paramètre Type de modèle a pour valeur Gradient boosté, un nombre plus élevé d’arbres peuvent produire des prévisions de modèle plus précises, mais risquent également de conduire à un surajustement des données d’entraînement. Pour éviter le surajustement des données, indiquez des valeurs pour les paramètres Profondeur d’arbre maximale, Régularisation L2 (Lambda), Réduction de perte minimale pour les divisions (Gamma) et Vitesse d’apprentissage (Eta). | Long |

Taille minimale des feuilles (Facultatif) | Nombre minimal d’observations requises pour conserver une feuille (c’est-à-dire le nœud terminal d’un arbre sans fractionnements supplémentaires). La valeur minimale par défaut est de 5 pour la régression et de 1 pour la classification. Pour les jeux de données très volumineux, l’augmentation de ces nombres aura pour effet de réduire le temps d’exécution de l’outil. | Long |

Profondeur d’arbre maximale (Facultatif) | Nombre maximum de fractionnements pouvant être effectués pour un arbre. Si la profondeur maximum est élevée, le nombre de fractionnements créés augmente, ce qui accroît les risques de sur-ajustement du modèle. Si le paramètre Type de modèle a pour valeur Basé sur une forêt, la valeur par défaut est dynamique et dépend du nombre d’arbres créés ainsi que du nombre de variables incluses. Si le paramètre Type de modèle a pour valeur Gradient boosté, la valeur par défaut est 6. | Long |

Données disponibles par arbre (%) (Facultatif) | Pourcentage des valeurs Entités d’entraînement en entrée qui seront utilisées pour chaque arbre décisionnel. La valeur par défaut est 100 pour cent des données. Les échantillons de chaque arbre sont sélectionnés de manière aléatoire à partir des deux tiers des données spécifiées. Chaque arbre décisionnel de la forêt est créé à partir d’un échantillon aléatoire ou d’un sous-ensemble (équivalant approximativement aux deux tiers) des données d’entraînement disponibles. Si un pourcentage plus faible de données est utilisé en entrée pour chaque arbre décisionnel, l’outil s’exécute plus rapidement sur les jeux de données très volumineux. | Long |

Nombre de variables échantillonnées de manière aléatoire (Facultatif) | Nombre de variables explicatives qui seront utilisées pour créer chaque arbre décisionnel. Chaque arbre décisionnel des modèles basés sur une forêt et à gradient boosté est créé à l’aide d’un sous-ensemble aléatoire des variables explicatives spécifiées. L’augmentation du nombre de variables utilisées dans chaque arbre décisionnel augmente la probabilité de sur-ajustement du modèle, en particulier si une ou plusieurs variables dominent. Par défaut, la racine carrée du nombre total de variables explicatives (champs, distances et rasters confondus) est utilisée si la valeur de Variable à prévoir est catégorielle, ou le nombre total de variables explicatives (champs, distances et rasters confondus) est divisé par 3 si la valeur de Variable à prévoir est numérique. | Long |

Données d’entraînement exclues pour la validation (%) (Facultatif) | Pourcentage (entre 0 pour cent et 50 pour cent) des valeurs Entités d’entraînement en entrée qui sera réservé en guise de jeu de données de test pour la validation. Le modèle est entraîné sans ce sous-ensemble aléatoire de données et les valeurs prévues par le modèle pour ces entités sont comparées aux valeurs observées. La valeur par défaut est 10 pour cent. | Double |

Table des performances de classification en sortie (Matrice de confusion) (Facultatif) | Matrice de confusion qui résume les performances du modèle créé sur les données de validation. La matrice compare les catégories prévues par le modèle pour les données de validation aux catégories réelles. Cette table peut être utilisée pour calculer des diagnostics supplémentaires qui ne figurent pas dans les messages en sortie. Ce paramètre est disponible lorsque la valeur de Variable à prévoir est catégorielle et que le paramètre Traiter comme catégoriel est coché. | Table |

Table de validation en sortie (Facultatif) | Table qui contient le R2 pour chaque modèle si la valeur de Variable à prévoir n’est pas catégorielle, ou la précision de chaque modèle si la valeur est catégorielle. Cette table inclut un diagramme à barres de la distribution des précisions ou des valeurs R2. Cette distribution permet d’évaluer la stabilité du modèle. Ce paramètre est disponible lorsque la valeur de Nombre d’exécutions pour la validation est supérieure à 2. | Table |

Compenser les catégories creuses (Facultatif) | Indique si chaque catégorie du jeu de données d’entraînement, quelle que soit sa fréquence, est représentée dans chaque arbre. Ce paramètre est disponible lorsque le paramètre Type de modèle a pour valeur Basé sur une forêt.

| Boolean |

Nombre d’exécutions pour la validation (Facultatif) | Le nombre d’itérations de l’outil. Vous pouvez afficher la distribution des valeurs R-carré (continues) ou des précisions (catégorielles) de tous les modèles à l’aide du paramètre Table de validation en sortie. Si le paramètre Type de prévision a pour valeur Prévoir un raster ou Prévoir des entités, le modèle qui a produit la valeur R-carré ou la précision médiane est utilisé pour effectuer des prévisions. L’utilisation de la valeur médiane favorise la stabilité des prévisions. | Long |

Calculer l’incertitude (Facultatif) | Spécifie si l’incertitude de prévision sera calculée lorsque vous effectuez l’entraînement, une prévision sur des entités, une prévision sur un raster. Ce paramètre est disponible lorsque le paramètre Type de modèle a pour valeur Basé sur une forêt.

| Boolean |

Fichier du modèle entraîné en sortie. (Facultatif) | Un fichier de modèle en sortie dans lequel sera enregistré le modèle entraîné qui pourra être utilisé ultérieurement pour effectuer des prévisions. | File |

Type de modèle (Facultatif) | Spécifie la méthode utilisée pour créer le modèle.

| String |

Régularisation L2 (Lambda) (Facultatif) | Terme de régularisation qui réduit la sensibilité du modèle aux entités individuelles. Si cette valeur augmente, le modèle devient plus conservateur et empêche le surajustement des données d’entraînement. Si la valeur est égale à 0, le modèle devient le modèle Boosting de gradient traditionnel. La valeur par défaut est 1. Ce paramètre est disponible lorsque le paramètre Type de modèle a pour valeur Gradient boosté. | Double |

Réduction de perte minimale pour les divisions (Gamma) (Facultatif) | Seuil auquel la réduction de perte minimale doit diviser les arbres. Les divisions potentielles sont évaluées quant à leur réduction de perte. Si la réduction de perte de la division candidate est plus élevée que cette valeur de seuil, la partition a lieu. Des valeurs de seuil plus élevées empêchent le surajustement et génèrent des modèles plus conservateurs avec moins de partitions. La valeur par défaut est 0. Ce paramètre est disponible lorsque le paramètre Type de modèle a pour valeur Gradient boosté. | Double |

Vitesse d’apprentissage (Eta) (Facultatif) | Valeur qui réduit la contribution de chaque arbre à la prévision finale. La valeur doit être supérieure à 0 et inférieure ou égale à 1. Une vitesse d’apprentissage plus faible empêche le surajustement du modèle, mais peut nécessiter des temps de calcul plus longs. La valeur par défaut est de 0,3. Ce paramètre est disponible lorsque le paramètre Type de modèle a pour valeur Gradient boosté. | Double |

Nombre maximal de groupes pour la recherche de divisions (Facultatif) | Nombre de groupes selon lequel les données d’entraînement sont divisées pour la recherche du meilleur point de division. La valeur doit être différente de 1. La valeur par défaut est 0, ce qui correspond à l’utilisation d’un algorithme glouton. Un algorithme glouton crée une division candidate à chaque point de données. Il est déconseillé d’indiquer un nombre trop faible de groupes, car cela génère des performances de prévision de modèle médiocres. Ce paramètre est disponible lorsque le paramètre Type de modèle a pour valeur Gradient boosté. | Long |

Optimiser les paramètres (Facultatif) | Indique si une méthode d’optimisation est utilisée pour rechercher le jeu d’hyperparamètres qui permet d’atteindre des performances de modèle optimales.

| Boolean |

Méthode d’optimisation (Facultatif) | Spécifie la méthode d’optimisation utilisée pour sélectionner et tester des points de recherche afin de trouver le jeu optimal d’hyperparamètres. Les points de recherche sont des combinaisons d’hyperparamètres au sein de l’espace de recherche ; ils sont spécifiés par le paramètre Réglage des paramètres de modèle. Cette sortie est disponible lorsque le paramètre Paramètres d’optimisation est coché.

| String |

Optimiser la cible (Objectif) (Facultatif) | Spécifie la fonction ou la valeur de l’objectif qui sera réduite ou augmentée pour la recherche du jeu optimal d’hyperparamètres.

| String |

Nombre d’exécutions pour les jeux de paramètres (Facultatif) | Nombre de points de recherche au sein de l’espace de recherche spécifiés par le paramètre Réglage des paramètres de modèle qui seront testés. Ce paramètre est disponible lorsque le paramètre Méthode d’optimisation a pour valeur Recherche aléatoire (Rapide) ou Recherche aléatoire (Robuste). | Long |

Réglage des paramètres de modèle (Facultatif) | Liste des hyperparamètres et de leurs espaces de recherche. Personnalisez l’espace de recherche de chaque hyperparamètre en fournissant une limite inférieure, une limite supérieure et un intervalle. La limite inférieure et la limite supérieure spécifient la plage des valeurs possibles de l’hyperparamètre. Voici la plage des valeurs valides pour chaque hyperparamètre :

| Value Table |

Table d’optimisation des paramètres en sortie (Facultatif) | Table qui contient les réglages des paramètres et les valeurs d’objectif de chaque essai d’optimisation. La sortie inclut un diagramme de tous les essais et de leurs valeurs d’objectif. Cette option est disponible lorsque le paramètre Optimiser les paramètres est coché. | Table |

Inclure toutes les probabilités de prévision (Facultatif) | Pour les variables catégorielles à prévoir, cette option indique s’il convient de prévoir la probabilité de toutes les catégories de la variable catégorielle ou seulement la probabilité de la catégorie de l’enregistrement. Considérons, par exemple, une variable catégorielle avec les catégories A, B et C. Si le premier enregistrement correspond à la catégorie B, utilisez ce paramètre pour indiquer si la probabilité des catégories A, B et C est à prévoir ou seulement la probabilité de la catégorie B de l’enregistrement.

| Boolean |

Sortie obtenue

| Étiquette | Explication | Type de données |

| Couches de raster d’incertitude en sortie | Lorsque le paramètre Calculer l’incertitude est sélectionné, l’outil calcule un intervalle de prévision de 90 pour cent autour de chaque valeur prévue du paramètre Variable à prévoir. | Raster Layer |