Disponible avec une licence Image Analyst.

La fonctionnalité Full Motion Video (FMV) de l’extension ArcGIS Image Analyst propose des fonctions de lecture et d’analyse géospatiale pour les vidéos compatibles avec FMV. La compatibilité FMV fait référence à la combinaison d’un flux vidéo et des métadonnées associées dans un même fichier vidéo, ce qui rend la vidéo géospatiale. Les systèmes de capteur collectent les informations relatives à l’orientation de la caméra, la position et l’attitude de la plateforme, ainsi que d’autres données, et les encodent dans le flux vidéo afin que chaque image vidéo soit associée à des informations de géopositionnement.

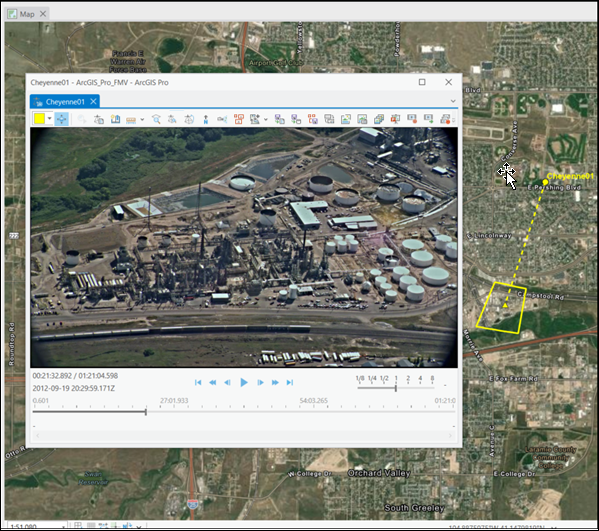

Ces données vidéo géospatiales, avec les fonctions algorithmiques de ArcGIS AllSource, permettent de visualiser et manipuler la vidéo tout en prêtant attention aux dynamiques des capteurs et au champ de visibilité, et d’afficher ces informations dans la vue cartographique. Elles permettent également d’analyser et de mettre à jour les données d’entités dans la vue vidéo ou dans la vue cartographique, et d’appliquer des annotations à main levée sur la vidéo.

FMV utilise les métadonnées pour convertir facilement les coordonnées entre l’espace image vidéo et l’espace cartographique, de la même manière que le système de coordonnées d’image dans l’analyse de l’espace image transforme les images fixes. Cette conversion constitue la base de l’interprétation des données vidéo dans le contexte intégral de toutes les autres données géospatiales et informations de votre SIG. Par exemple, vous pouvez afficher l’emprise d’image vidéo, le centre des images et la position de la plateforme d’imagerie sur la vue cartographique à mesure de la lecture de la vidéo, avec vos couches SIG, telles que les bâtiments et leurs ID, les barrières géographiques et toutes autres informations pertinentes.

Vous pouvez procéder à l’analyse forensique ou temps réel des données FMV, immédiatement après une collecte. Cela convient parfaitement pour la perception de situation, car il s’agit souvent de l’imagerie la plus actuelle disponible pour une localisation. Par exemple, si votre tâche consiste à évaluer les dégâts après une catastrophe naturelle, vous pouvez utiliser FMV pour analyser les dernières données vidéo collectées depuis un drone, ainsi que les couches de données SIG existantes. Comme l’emprise vidéo est visible sur la carte, vous savez exactement quels bâtiments et quelle infrastructure sont visibles sur la vidéo, et vous pouvez évaluer leur condition, marquer les entités au sol dans la vidéo et sur la carte, marquer leur localisation d’un géosignet et les décrire dans des notes. FMV est conçu pour évaluer, analyser et diffuser rapidement des informations exploitables pour faciliter les décisions.

Pour plus d’informations sur FMV, reportez-vous au Forum aux questions.

Fonctionnalités et avantages de FMV

FMV utilise des métadonnées essentielles, fournit des outils de traitement visuel et analytique et offre les fonctionnalités ArcGIS AllSource suivantes pour la prise en charge des processus de projet et des processus indispensables.

- FMV est entièrement intégré à ArcGIS AllSource et utilise l’architecture système, les modèles de données, les outils et fonctionnalités ainsi que le partage dans ArcGIS.

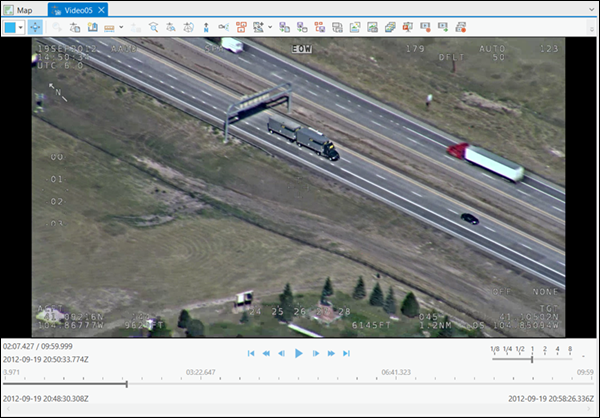

- Vous pouvez consulter et analyser des vidéos en direct et des vidéos archivées.

- Déplacez le lecteur vidéo n’importe où sur votre écran d’ordinateur, redimensionnez-le, réduisez-le et fermez-le.

- Le lecteur vidéo est associé à l’affichage cartographique, ce qui permet les opérations suivantes :

- Afficher l’emprise vidéo, la localisation du capteur et le champ de vision sur la carte.

- Toutes les informations collectées dans le lecteur vidéo sont projetées et apparaissent sur la carte, avec les données SIG existantes.

- Mettre à jour la carte pour zoomer sur l’image vidéo et suivre les vidéos sur la carte.

- Ouvrez et lisez plusieurs vidéos en même temps. Chaque vidéo et ses informations associées sont identifiées par une couleur unique lorsqu’elles sont affichées sur la carte.

- Utilisez les contrôles de lecture intuitifs, les outils de capture d’images et de clips vidéo et les outils d’analyse.

- Afficher les métadonnées en temps réel.

- Créer et gérer des géosignets.

- Marquer des emplacements et des phénomènes qui présentent un intérêt.

- L’affichage est accéléré par un GPU.

Ces fonctionnalités constituent la base des processus qui intègrent un contexte spatial dans le processus d’analyse vidéo.

Utilisations de FMV

Les données FMV sont principalement utilisées pour renforcer les décisions dans les environnements opérationnels. Comprendre qui utilise les données FMV et comment elles sont collectées et utilisées permet d’obtenir un contexte important pour évaluer les fonctions de FMV.

Secteurs d’activité qui utilisent FMV

FMV permet de surveiller les localisations distantes, inaccessibles ou dangereuses. Les types d’organisations qui utilisent FMV sont notamment les suivants :

- Sécurité civile et gestion des situations d’urgence

- Défense

- Compagnies pétrolières

- Gouvernements fédéraux et autorités locales

- Patrouille frontalière

- Utilitaires

- Professionnels des ressources naturelles

Voici quelques types d’applications de FMV :

- Gestion des situations d’urgence et sécurité civile

- Perception de situation

- Evaluation des dégâts

- Réponse

- Atténuation des risques

- Surveillance de sécurité

- Gestion des ressources

- Cartographie, surveillance et gestion des couloirs

- Transmission de service, tels que les réseaux de distribution d’électricité, de gaz, d’eau ou d’autres modes d’acheminement

- Transports, tels que les routes, ponts, voies ferrées, autoroutes et postes frontières aériens, terrestres et maritimes

- Communication, telle que les antennes-relais de téléphonie mobile et les infrastructures

- Hydrologie, telle que les infrastructures naturelles et humaines

- Zones riveraines, telles que les mémoires tampon de flux par portée, habitat, cartographie de la diversité et liens

- Défense

- Intelligence, surveillance et reconnaissance

- Support de mission

- Contre-espionnage

- Surveillance des infrastructures

- Inventaire

- Nouveau développement

- Vérification des dessins tels que construits et planifiés

- Conformité et sécurité

Collecte des données FMV

L’application Full Motion Video dans ArcGIS AllSource utilise les données collectées à partir de différentes plateformes de télédétection. Les métadonnées et données vidéo sont collectées simultanément, puis les métadonnées sont encodées dans le fichier vidéo soit en temps réel dans la plateforme de capteur (compatible MISB), soit ultérieurement lors d’une étape de traitement nommée le multiplexage.

Les données FMV sont collectées à partir de différentes plateformes de capteur, parmi lesquelles :

- Drones (aéronefs sans pilote, systèmes aériens sans pilote et aéronefs pilotés à distance)

- Plateformes aériennes de type hélicoptère ou à ailes fixes

- Capteurs spatiaux en orbite

- Caméras montées sur véhicule

- Caméras et appareils mobiles portables

- Appareils stationnaires pour une surveillance constante

Les formats vidéo pris en charge, y compris les formats 4K haute résolution, sont répertoriés dans la table suivante :

| Description | Extension |

|---|---|

Fichier MOV | .mov |

Flux de transport MPEG-2 | .ts |

Flux de programme MPEG-2 | .ps |

Fichier MPEG | .mpg |

Fichier MPEG-2 | .mpg2 |

Fichier MPEG-2 | .mp2 |

Fichier MPEG | .mpeg |

VLC (mpeg2) | .mpeg2 |

Film MPEG-4 | .mp4 |

Fichier MPEG-4 | .mpg4 |

MPEG-Dash | .mpd |

Fichier vidéo H264¹ | .h264 |

Fichier vidéo H265¹ | .h265 |

Fichier média VLC (mpeg4) | .mpeg4 |

Fichier média VLC (vob) | .vob |

HLS (à débit adaptatif [Adaptive Bitrate ou ABR]) | .m3u8 |

¹ Nécessite une opération de multiplexage |

Configuration système requise pour Full Motion Video

Les configurations système requises minimale, recommandée et optimale pour une utilisation de Full Motion Video dans ArcGIS AllSource sont décrites ci-après. La configuration système requise minimale ne permet la lecture que d’une seule vidéo. La configuration système requise recommandée permet d’utiliser les outils Full Motion Video lors de la lecture d’une seule vidéo. La configuration système requise optimale permet d’utiliser les outils Full Motion Video lors de la lecture de plusieurs vidéos.

| Élément | Pris en charge et recommandé |

|---|---|

Processeur | Minimale : 4 cœurs à 2,6 GHz, multithreading simultané. Le multithreading simultané, ou hyperthreading, des processeurs comporte généralement deux threads par cœur. Un processeur double cœur multithread possède quatre threads disponibles pour le traitement, tandis qu’un processeur à six cœurs multithread en possède douze. Recommandée : 6 cœurs. Optimale : 10 cœurs. |

Fonctionnalités de Full Motion Video

Full Motion Video prend en charge différents environnements opérationnels, de la perception de situation et de l’intervention d’urgence avec contrainte temporelle à l’aide d’une vidéo diffusée en continu en direct à l’analyse de vidéos archivées quotidiennement ou toutes les heures à des fins de surveillance en passant par l’analyse forensique de données historiques archivées. Chaque type d’application requiert des outils d’analyse et de visualisation intuitifs pour identifier et enregistrer rapidement des entités ou situations présentant un intérêt et pour diffuser les informations extraites auprès des décideurs et parties prenantes. Les fonctionnalités Full Motion Video comme aide à la prise de décision sont classées dans les différentes fonctions essentielles ci-dessous.

Onglets vidéo contextuels

Lorsque vous chargez une vidéo sur la carte et la sélectionnez dans la fenêtre Contents (Contenu), les onglets contextuels Standalone Video (Vidéo autonome) et Player (Lecteur) s’affichent.

Onglet Vidéo autonome

Lorsqu’une vidéo est chargée à l’écran, le fichier vidéo est répertorié dans la fenêtre Contents (Contenu) et l’onglet Standalone Video (Vidéo autonome) est activé. Les outils de l’onglet Standalone Video (Vidéo autonome) permettent de gérer les données vidéo. Cet onglet s’organise autour des groupes Open (Ouvrir), Bookmarks (Géosignets), Save (Enregistrer) et Manage (Gérer).

Les outils de l’onglet Standalone Video (Vidéo autonome) sont décrits dans l’onglet Vidéo autonome.

Onglet Lecteur

L’onglet contextuel Player (Lecteur) est activé lorsque vous sélectionnez une vidéo dans la fenêtre Contents (Contenu).

L’onglet Player (Lecteur) contient des outils pour naviguer dans la vidéo, ajouter et gérer des graphiques et consulter les métadonnées de la vidéo. Ces outils sont aussi disponibles dans le lecteur.

Les outils permettent notamment de zoomer sur la vue cartographique associée pour afficher l’image vidéo entière au sol, d’afficher la trace au sol du capteur et le champ de vision de l’image vidéo et de zoomer et se déplacer sur la carte pour suivre la vidéo au sol. Ces outils vous apportent un contexte géographique lorsque vous utilisez des données vidéo.

Lecteur vidéo

Le lecteur vidéo comprend des contrôles vidéo standard, tels que la lecture, l’avance rapide, le retour rapide, l’avance d’une image, le recul d’une image, l’accès au début ou l’accès à la fin de la vidéo. Vous pouvez effectuer un zoom avant et faire défiler une vidéo lorsqu’elle est en mode lecture ou en pause. Le lecteur vidéo fonctionne avec les scènes globales et locales. La fonctionnalité Orient Scene Camera (Orienter la caméra de la scène) oriente la caméra de la vue de scène d’après la perspective du capteur vidéo.

D’autres outils permettent de capturer, d’annoter et d’enregistrer des géosignets vidéo, de capturer des images vidéo uniques et d’exporter des clips vidéo.

Géosignets

La création de géosignets vidéo est une fonction importante pour enregistrer des phénomènes et entités d’intérêt lors de l’analyse d’une vidéo. Vous pouvez collecter des géosignets vidéo dans les différents modes de lecture d’une vidéo (lecture, pause, avance rapide et retour rapide). Vous pouvez décrire les géosignets dans la fenêtre Bookmark (Géosignet) qui s’ouvre lorsque vous collectez un géosignet vidéo. Les géosignets sont collectés et gérés dans la fenêtre Bookmarks (Géosignets) disponible dans ArcGIS AllSource, sous l’onglet Map (Carte) du groupe Navigate (Naviguer).

Ajouter des métadonnées aux vidéos

Dans FMV, vous pouvez uniquement utiliser des vidéos qui contiennent des métadonnées essentielles. Les systèmes de collecte de données vidéo aériens professionnels collectent généralement les métadonnées requises et les encodent dans le fichier vidéo en temps réel. Ces données sont saisies directement dans l’application Full Motion Video, en mode de diffusion en continu en direct ou depuis un fichier archivé.

Les systèmes de collecte vidéo grand public produisent généralement des fichiers de métadonnées et de données vidéo distincts qui doivent être combinés dans un fichier vidéo FMV unique. Ce traitement est réalisé dans le logiciel et se nomme le multiplexage. Full Motion Video comprend l’outil Multiplexeur vidéo, qui encode les métadonnées appropriées à l’emplacement exact du fichier vidéo pour produire un seul fichier vidéo compatible avec FMV. Chaque fichier de métadonnées et vidéo utilise des horodatages pour synchroniser l’encodage des métadonnées appropriées à la position convenue dans le fichier vidéo.

Les métadonnées sont générées à partir de capteurs appropriés, tels qu’un GPS pour la position x,y,z, l’altimètre et l’unité de mesure inertielle (UMI), ou d’autres sources de données pour l’orientation de la caméra. Le fichier de métadonnées doit être au format CSV (valeurs séparées par des virgules).

Les métadonnées FMV permettent de calculer la trajectoire de vol du capteur vidéo, le centre de l’image vidéo et l’emprise au sol des images vidéo. FMV prend également en charge les spécifications de métadonnées MISB (Motion Imagery Standards Board). Tous les paramètres MISB qui sont fournis seront encodés dans la vidéo finale compatible avec FMV.

Un ensemble des paramètres Full Motion Video inclut les coordonnées cartographiques des quatre angles de l’image vidéo projetée au sol. Si les coordonnées cartographiques de ces quatre angles sont fournies, elles sont utilisées. Sinon, l’application calcule l’emprise vidéo à partir d’un sous-ensemble des paramètres requis.

Pour calculer et afficher les points d’angle relatifs de l’emprise d’image vidéo en tant que contour d’image sur la carte, les 12 champs de métadonnées répertoriés ci-dessous sont obligatoires :

- Horodatage de précision

- Latitude du capteur

- Longitude du capteur

- Hauteur ellipsoïdale du capteur ou altitude réelle du capteur

- Angle de cap de la plateforme

- Angle de tangage de la plateforme

- Angle de roulis de la plateforme

- Angle de roulis relatif du capteur

- Angle d’élévation relative du capteur

- Angle d’azimut relatif du capteur

- Champ de vision horizontal du capteur

- Champ de vision vertical du capteur

Une fois les métadonnées complètes et précises, l’application calcule les angles de l’image vidéo et donc la taille, la forme et la position du contour de l’image vidéo, qui peut alors s’afficher sur la carte. Ces 12 champs comprennent les métadonnées minimales requises pour calculer la transformation entre la vidéo et la carte, pour afficher l’emprise vidéo sur la carte et pour activer d’autres fonctions telles que la numérisation et le marquage de la vidéo et de la carte.

Full Motion Video prend en charge les données VMTI (Video Moving Target Indicator), basées sur des méthodes de suivi d’objet dans l’imagerie animée. Si les données VMTI sont enregistrées dans un fichier distinct du fichier vidéo associé, vous pouvez les encoder dans le fichier vidéo à l’aide de l’outil Multiplexeur vidéo.

Les performances du fichier vidéo multiplexé obtenu dépendent du type et de la qualité des données contenues dans le fichier de métadonnées et du degré de précision avec lequel les fichiers de métadonnées et de données vidéo sont synchronisés. Si les métadonnées ne sont pas précises ou comportent des anomalies, ces différences sont encodées dans la vidéo et affichées sur la carte lors de la lecture de la vidéo. Si le fichier metadata.csv contient uniquement les champs UNIX Time Stamp, Sensor Latitude et Sensor Longitude, la position du capteur apparaît sur la carte, mais l’emprise des images vidéo n’est pas affichée et certaines fonctions, telles que la numérisation des entités et la mesure de la distance dans la vidéo, ne sont pas prises en charge.

Les métadonnées peuvent être saisies dans le modèle de métadonnées FMV_Multiplexer_Field_Mapping_Template.csv qui se trouve dans le dossier C:\Program Files\ArcGIS\Pro\Resources\FullMotionVideo. Ce modèle contient les 12 champs de métadonnées essentiels pour calculer l’emprise de l’image vidéo et des champs supplémentaires inclus dans la spécification MISB. Si les noms de champ de métadonnées ne concordent pas avec ceux requis pour le modèle de métadonnées, ils peuvent être appariés avec les noms de champ du modèle de métadonnées dans le modèle FMV_Multiplexer_Field_Mapping_Template.csv.

Dans l’idéal, les métadonnées et données vidéo sont temporellement synchrones. Si l’horodatage qui lie la vidéo et les métadonnées n’est pas synchronisé avec précision, l’emprise de la vidéo et la position des capteurs sur la carte sont décalées par rapport à la vue dans le lecteur vidéo. Si le décalage temporel est observable et cohérent, le multiplexeur peut ajuster le minutage des métadonnées sur celui de la vidéo. Les décalages temporels sont appliqués en créant un fichier .csv facultatif et en le définissant comme entrée dans l’outil Multiplexeur vidéo qui identifie la position du décalage dans la vidéo et sa différence temporelle associée. Utilisez le modèle FMV_Multiplexer_TimeShift_Template.csv du dossier C:\Program Files\ArcGIS\Pro\Resources\FullMotionVideo pour ajuster les décalages. Le modèle contient des colonnes étiquetéeselapsed time, qui correspond à la position du décalage temporel dans la vidéo et time shift, qui est la durée du décalage. Si le décalage temporel entre la vidéo et les métadonnées est incohérent, vous pouvez répertorier plusieurs positions dans la vidéo avec le décalage temporel associé dans le modèle. Cela indique au multiplexeur où positionner les métadonnées appropriées par rapport au minutage de la vidéo.

Suivi d’objet

Full Motion Video prend en charge deux méthodes de suivi d’objet : indication de cible mobile vidéo (VMTI) et suivi basé sur le Deep Learning. Les méthodes VMTI suivent l’objet manuellement ou automatiquement et encodent sa position dans une image vidéo donnée. Un identifiant (ID) et un rectangle d’emprise est associé à chaque objet, qui est enregistré dans la vidéo archivée. Lors de la lecture de la vidéo, les informations associées à l’objet VMTI s’affichent. Full Motion Video exige que les métadonnées vidéo encodées respectent la norme Video Moving Target Indicator and Track Metadata du MISB (Motion Imagery Standards Board) (ST 0903).

La fonctionnalité de suivi d’objet basée sur le Deep Learning fournit des outils automatisés et assistés par ordinateur adaptés à diverses situations observées lors de l’identification et du suivi des objets d’une imagerie vidéo. Elle met la technologie de Deep Learning au service de la détection, de l’extraction et de l’appariement des objets. Créez un modèle de Deep Learning pour identifier des objets et classes d’entités spécifiques, puis utilisez la suite d’outils pour identifier, sélectionner et suivre ces objets d’intérêt. Vous pouvez numériser les centroïdes du rectangle d’identification d’un objet et les enregistrer sous forme de classe de points dans la géodatabase du projet. Vous pouvez ensuite afficher les objets pendant la lecture de la vidéo archivée.

Remarque :

Vous devez installer les paquetages de structure de Deep Learning pour exécuter un suivi d’objet basé sur le Deep Learning. Reportez-vous à la configuration système requise pour en savoir plus.

Résumé

Les caractéristiques géospatiales de Full Motion Video conviennent parfaitement aux applications d’analyse forensique ou temps réel et de perception de la situation. La capacité de projection et d’affichage de la trajectoire de vol et de l’emprise de l’image vidéo sur la carte fournit un contexte important à la vidéo et permet la collecte bidirectionnelle des entités dans le lecteur vidéo et la carte.

Ces fonctionnalités, alliées aux géosignets vidéo annotés, permettent à un analyste d’identifier des segments ou des images vidéo spécifiques pour réaliser des analyses plus poussées et partager ces informations avec d’autres intervenants. En intégrant la vidéo FMV aux fonctions SIG entières, vous pouvez synthétiser des informations contextuelles importantes pour favoriser une prise de décision éclairée dans des environnements opérationnels.

Vous avez un commentaire à formuler concernant cette rubrique ?