Disponible avec une licence Image Analyst.

En imagerie animée, il existe une fonctionnalité qui permet de suivre spécifiquement certains objets présents dans des données vidéo pendant leur lecture. Ces objets peuvent être fixes ou mobiles, disparaître puis réapparaître ou changer de forme (comme une personne montant dans un véhicule). La fonctionnalité de suivi d’objet en vidéo plein écran (FM, Full Motion Video) fournit des outils automatisés et assistés par ordinateur adaptés à diverses situations observées lors du suivi des objets d’une imagerie vidéo. Elle met les technologies de Deep Learning et de vision artificielle au service du suivi d’objets, de l’extraction d’entités et de l’appariement. Ainsi, vous pouvez créer un modèle de Deep Learning pour le suivi d’objets, puis utiliser la suite d’outils pour sélectionner et suivre un objet d’intérêt. Les centroïdes correspondants aux rectangles d’identification de l’objet peuvent être numérisés et enregistrés sous forme de classe de points dans la géodatabase du projet. Les points enregistrés peuvent ensuite être affichés pendant la lecture de la vidéo archivée.

Conditions requises

La fonctionnalité de suivi d’objets en FMV est disponible dans ArcGIS AllSource avec l’extension ArcGIS Image Analyst.

Remarque :

Assurez-vous que vous disposez de la version la plus récente de vos pilotes de carte vidéo.

Modèle de Deep Learning

Le suivi d’objets dans une vidéo nécessite un ou plusieurs modèles de Deep Learning entraînés. L’efficacité du suivi dépend de la qualité des données d’échantillon d’entraînement pour Deep Learning et du degré de relation entre l’objet d’intérêt et les données d’entraînement. Par exemple, pour suivre un camion circulant sur une autoroute, vous devez avoir étiqueté les échantillons d’entraînement de camions sous plusieurs angles. La source des échantillons d’entraînement (images annotées) doit être une imagerie animée. Les échantillons d’entraînement étiquetés sont utilisés pour entraîner le modèle de Deep Learning à suivre des objets, en l’occurrence des camions. Le modèle donnera des résultats limités pour le suivi d’objets d’un aspect différent, comme les voitures, mais de bien meilleurs résultats pour le suivi de bus ou de véhicules loisirs.

Vous devez installer les paquetages de structure de Deep Learning pour exécuter des processus de Deep Learning dans ArcGIS AllSource. Utilisez divers outils pour préparer les données d’entraînement de l’imagerie vidéo et fixe, étiqueter les objets, créer des modèles de Deep Learning, définir l’inférence et examiner les résultats. Pour savoir comment installer ces paquetages, reportez-vous à la rubrique Installer des structures de Deep Learning pour ArcGIS.

Le Deep learning sollicite beaucoup de ressources de calcul, c’est pourquoi il est recommandé de s’équiper d’un processeur graphique puissant avec prise en charge de la fonctionnalité de calcul CUDA, version 6.0 ou ultérieure.

Pour plus d’informations sur le Deep Learning et ses processus, reportez-vous aux rubriques Introduction au Deep Learning et Deep Learning dans ArcGIS Pro. Pour plus d’informations sur la suite d’outils de Deep Learning disponible dans ArcGIS, reportez-vous à la rubrique Présentation du jeu d’outils Deep Learning.

Onglet Suivi

L’onglet contextuel Tracking (Suivi) est activé lorsque vous sélectionnez une vidéo dans la fenêtre Contents (Contenu).

Remarque :

L’onglet Tracking (Suivi) est disponible une fois que les paquetages de Deep Learning sont installés et activés dans ArcGIS AllSource.Les outils du groupe Object Tracking (Suivi d’objets) vous permettent d’identifier et de gérer le suivi d’objets dans vos données vidéo :

- Tracking Pane (Fenêtre Suivi) - Ouvrez la fenêtre Object Tracking Display (Affichage du suivi d’objets), dans laquelle vous pouvez spécifier le modèle de Deep Learning pour le suivi d’objets et définir les paramètres.

- Enable (Activer) - Activez les outils interactifs de suivi d’objets.

- Add Object (Ajouter un objet) - Ajoutez un objet pour procéder au suivi d’objets en traçant interactivement un rectangle autour de l’objet.

- Reposition Object (Repositionner l’objet) - Cliquez sur le rectangle de suivi d’un objet existant pour le sélectionner, puis redessinez le rectangle autour de la position mise à jour de l’objet.

- Remove Object (Supprimer l’objet) - Cliquez sur le rectangle de suivi d’un objet existant pour arrêter le suivi actif de cet objet.

- Object(s) to Feature (Objet(s) vers entités) - Enregistrez les centroïdes des rectangles de détection d’objets comme nouvelle classe d’entités.

Fenêtre Suivi

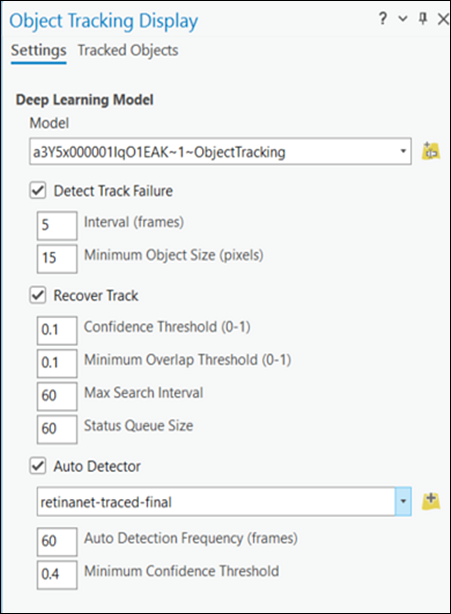

Cliquez sur le bouton Tracking Pane (Fenêtre Suivi) pour ouvrir la fenêtre Object Tracking Display (Affichage du suivi d’objets). La fenêtre comporte les onglets Settings (Paramètres) et Tracked Objects (Objets suivis).

Paramètres

Sur l’onglet Settings (Paramètres), vous pouvez sélectionner le modèle de Deep Learning et définir les paramètres du suivi des objets.

Cliquez sur le bouton Ajouter un modèle de suivi d’objets à l’aide d’un chemin d’accès local ou d’une URL  pour ouvrir la boîte de dialogue Add Deep Learning Model From Path (Ajouter un modèle de Deep Learning à partir d’un chemin d’accès). Pour définir le chemin d’accès au fichier de paquetage de votre modèle de Deep Learning (.dlpk), indiquez une URL ou sélectionnez le fichier dans un répertoire local. Vous pouvez définir un alias pour le nom du modèle dans la zone de texte Model (Modèle). Cliquez sur Add (Ajouter) pour charger le modèle et fermer la boîte de dialogue. Le nom du modèle figure maintenant dans la liste déroulante Model (Modèle) et peut y être sélectionné.

pour ouvrir la boîte de dialogue Add Deep Learning Model From Path (Ajouter un modèle de Deep Learning à partir d’un chemin d’accès). Pour définir le chemin d’accès au fichier de paquetage de votre modèle de Deep Learning (.dlpk), indiquez une URL ou sélectionnez le fichier dans un répertoire local. Vous pouvez définir un alias pour le nom du modèle dans la zone de texte Model (Modèle). Cliquez sur Add (Ajouter) pour charger le modèle et fermer la boîte de dialogue. Le nom du modèle figure maintenant dans la liste déroulante Model (Modèle) et peut y être sélectionné.

Dans l’onglet Settings (Paramètres), vous avez accès à des options pour contrôler le suivi des objets : Detect Track Failure (Détecter les erreurs de suivi), Recover track (Restaurer le suivi) et Auto Detector (Détecteur automatique).

- Detect Track Failure (Détecter les erreurs de suivi) - Indique si l’objet est suivi correctement sur la base de changements d’apparence. Cette case est cochée par défaut.

- Interval (frames) [Intervalle (images)] - Indique la fréquence, en nombre d’images, à laquelle l’application recherche les changements d’apparence des objets. La valeur par défaut est de 5 images.

- Minimum Object Size (pixels) [Taille d’objet minimale (pixels)] - Le suivi d’objets prend fin si un objet est plus petit que la taille définie. La valeur par défaut est de 10 pixels.

- Max Search Interval (Intervalle de recherche maximal) - Lorsqu’un objet est perdu, indique l’intervalle de recherche maximal défini en unités d’images vidéo. La valeur par défaut est 60.

- Status Queue Size (Taille de la file d’attente des statuts) - Indique le nombre d’images pour lequel le statut d’un objet est conservé en cas de perte de l’objet, avant l’expiration de l’intervalle de recherche.

- Recover Track (Restaurer le suivi) - Indique, le cas échéant, toute tentative de recherche d’un objet après la perte du suivi. Cette case est cochée par défaut.

- Confidence Threshold (0-1) [Seuil de confiance (0-1)] - Ratio minimal entre les entités d’image sources appariées et les entités d’objets recherchées pour une restauration réussie du suivi. Le seuil de confiance est une valeur comprise entre 0 et 1. La valeur par défaut est de 0,1.

- Minimum Overlap Threshold (0-1) [Seuil de superposition minimal (0-1)] - Ratio de superposition minimal entre l’objet détecté et l’objet recherché pour une restauration réussie du suivi. Le seuil est une valeur comprise entre 0 et 1. La valeur par défaut est de 0,1.

- Auto Detector (Détecteur automatique) - Indique si la détection et l’identification des objets cibles s’effectuent automatiquement à l’aide d’un modèle de détection de Deep Learning. Cette option est désactivée par défaut. Pour définir le chemin d’accès au fichier de paquetage de votre modèle de Deep Learning .dlpk, indiquez une URL ou sélectionnez le fichier dans un répertoire local.

Pour définir le chemin d’accès au fichier de votre modèle de Deep Learning (.emd), indiquez une URL ou sélectionnez le fichier dans un répertoire local.

- Auto Detector Frequency [Fréquence de détection automatique (images)] - Intervalle entre les exécutions successives du détecteur pour réidentifier et réaligner les objets cibles de la scène. L’exactitude est meilleure et les performances sont moindres avec des valeurs faibles. La valeur par défaut est 1.

- Minimum Confidence Threshold (Seuil de confiance minimal) - Valeur de confiance minimale pour le filtrage des détections. Le seuil est une valeur comprise entre 0 et 1. La valeur par défaut est de 0,4.

Objets suivis

Dans l’onglet Tracked Objects (Objets suivis), vous pouvez visualiser et gérer les objets suivis. Les valeurs ID, Source et Status (Statut) de chaque objet suivi sont répertoriées dans la table.

- ID - Identifiant unique de chaque objet suivi.

- Source - Fichier vidéo source dans lequel l’objet est identifié.

- Status (Statut) - Statut de chaque objet suivi : activement suivi, perdu ou faisant l’objet d’une recherche.

L’onglet Tracked Objects (Objets suivis) comporte également les cinq boutons d’action suivants dédiés à la gestion des objets suivis :

- Add (Ajouter) - Ajoutez un ou plusieurs objets à suivre en traçant un rectangle autour de chaque objet d’intérêt.

- Reposition (Repositionner) - Cliquez sur le rectangle de suivi d’un objet existant pour le sélectionner, puis replacez le rectangle autour de la position mise à jour de l’objet.

- Remove (Supprimer) - Cliquez sur le rectangle de suivi d’un objet existant pour arrêter le suivi actif de cet objet.

- Reassociate (Réassocier) - Réassociez l’objet répertorié au statut Lost (Perdu) en redessinant sa position mise à jour.

- Delete (Supprimer) - Retirez l’objet sélectionné de la liste des objets suivis.

Processus de suivi d’objets

Le processus de suivi d’objets se présente sommairement comme suit :

- Chargez un modèle de Deep Learning, puis définissez les paramètres de suivi sur l’onglet Settings (Paramètres) de la fenêtre Object Tracking Display (Affichage du suivi d’objets).

- Cliquez sur Enable (Activer) pour activer les outils de suivi d’objets.

- Cliquez sur Add Object (Ajouter un objet) pour tracer un rectangle autour de l’objet à suivre dans le lecteur vidéo. L’objet sera suivi dans chaque image vidéo.

Remarque :

Cette étape n’est pas nécessaire en mode Auto Detector (Détecteur automatique).

- Sur l’onglet Tracked Objects (Objets suivis), visualisez le statut des objets suivis.

- Si l’objet est masqué et le suivi est perdu, cliquez sur Reassociate (Réassocier), puis redessinez un rectangle autour de la position mise à jour de l’objet pour reprendre le suivi.

Remarque :

Cette étape n’est pas nécessaire en mode Auto Detector (Détecteur automatique).

- Si un rectangle de suivi n’est plus aligné par rapport à un objet en cours de suivi, cliquez sur Reposition (Repositionner), sélectionnez le rectangle de suivi de l’objet, puis repositionnez-le autour de l’objet.

Remarque :

Cette étape n’est pas nécessaire en mode Auto Detector (Détecteur automatique).

- Vous pouvez également cliquer sur Add (Ajouter) pour ajouter un objet à suivre.

Remarque :

Cette étape n’est pas nécessaire en mode Auto Detector (Détecteur automatique).

- Vous pouvez également cliquer sur Remove (Supprimer) pour arrêter le suivi actif d’un objet.

Remarque :

Cette étape n’est pas nécessaire en mode Auto Detector (Détecteur automatique).

- Sur l’onglet Tracking (Suivi), dans le groupe Object Tracking (Suivi d’objets), cliquez sur Object(s) to Feature (Objet(s) vers entités), puis indiquez l’emplacement en sortie et le nom préfixé à utiliser pour stocker les centroïdes d’objet dans une classe d’entités. Vous pouvez également préciser si la classe d’entités sera ajoutée à la carte, et indiquer la fréquence d’enregistrement des centroïdes en secondes.

Vous avez un commentaire à formuler concernant cette rubrique ?