Disponible avec une licence Image Analyst.

L’outil Calculer la précision pour la détection d’objets permet de calculer l’exactitude d’un modèle de Deep Learning en comparant les objets détectés par l’outil Détecter des objets à l’aide du Deep Learning aux données de référence de terrain. L’évaluation de l’exactitude d’un modèle repose sur quatre métriques d’exactitude : la précision moyenne (AP), le score F1, la moyenne de la précision moyenne (mAP) COCO et la courbe précision-rappel.

Interpréter les résultats du modèle

Pour bien comprendre les sorties générées par l’outil Calculer la précision pour la détection d’objets, il est important de comprendre les résultats du modèle de détection.

En matière de détection et classification des objets, un modèle peut prédire une classe positive ou une classe négative, et les prédictions peuvent être vraies ou fausses. Par exemple, en cas de détection de la présence d’arbres dans une image, la classe positive serait "Tree" et la classe négative serait "No Tree". Une prédiction est dite vraie lorsqu’elle est correcte. Inversement, une prédiction est dite fausse lorsqu’elle est incorrecte.

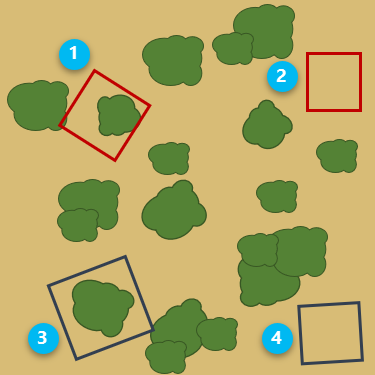

Dans l’image ci-après, les cadres de délimitation rouges indiquent une prédiction positive pour laquelle le modèle a prédit la présence d’un arbre. Les cadres de délimitation bleu foncé indiquent une prédiction négative pour laquelle le modèle a prédit l’absence d’arbre.

L’interprétation de chaque cadre de délimitation est développée dans le tableau ci-dessous.

| Nombre | Description |

|---|---|

| Vrai positif - La prédiction par le modèle de la présence d’un arbre est correcte. |

| Faux positif - La prédiction par le modèle de la présence d’un arbre est incorrecte. |

| Faux négatif - La prédiction par le modèle de l’absence d’arbre est incorrecte. |

| Vrai négatif - La prédiction par le modèle de l’absence d’arbre est correcte. |

Sorties d’exactitude

L’exactitude d’un modèle de détection d’objets dépend de la qualité des échantillons d’entraînement et de leur nombre, de l’imagerie en entrée, des paramètres de modèle et du seuil d’exactitude requis.

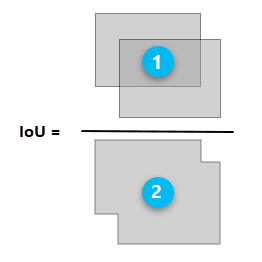

Le ratio d’intersection sur union (IoU) est utilisé comme seuil pour déterminer si un résultat prédit est un vrai positif ou un faux positif. Le ratio est l’envergure de la superposition entre la zone de délimitation autour d’un objet prédit et la zone de délimitation autour des données de référence de terrain.

| Zone d’intersection de la zone de délimitation prédite et de la zone de délimitation de référence de terrain |

| Zone totale de la zone de délimitation prédite et de la zone de délimitation de référence de terrain combinées |

Le tableau d’exactitude en sortie et le rapport d’exactitude générés par l’outil Calculer la précision pour la détection d’objets comportent chacun une série de métriques d’exactitude qui dépendent du seuil d’IoU (Intersection over Union) et de la performance du modèle. Voici la description des métriques d’exactitude :

- Precision - La précision est le ratio du nombre de vrais positifs par rapport au nombre total de prédictions positives. Par exemple, si le modèle a détecté 100 arbres, et qu’il y en a 90, la précision est de 90 pour cent.

Precision = (True Positive)/(True Positive + False Positive) - Recall - Le rappel est le ratio du nombre de vrais positifs par rapport au nombre total d’objets réels (pertinents). Par exemple, si le modèle a correctement détecté 75 arbres dans une image, et que l’image en compte réellement 100, le rappel est de 75 pour cent.

Recall = (True Positive)/(True Positive + False Negative) - F1 score - Le score F1 est une moyenne pondérée de la précision et du rappel. Ses valeurs sont comprises entre 0 et 1, où 1 correspond à l’exactitude la plus élevée.

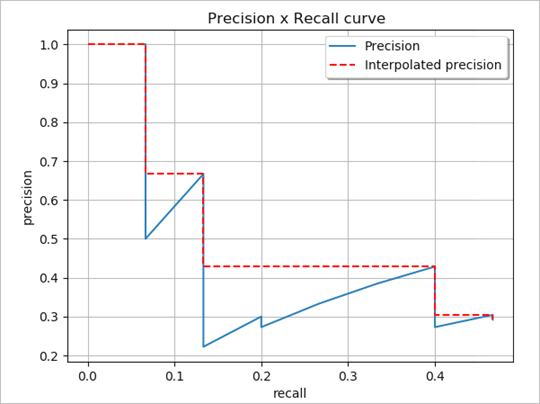

F1 score = (Precision × Recall)/[(Precision + Recall)/2] - Courbe précision-rappel - Il s’agit d’une représentation graphique de la précision (en abscisses) et du rappel (en ordonnées), qui est utilisée comme moyen d’évaluation de la performance d’un modèle de détection d’objets. Le modèle est considéré comme un bon modèle prédictif si la précision reste élevée alors que le rappel diminue.

Affichage de la courbe précision-rappel (Padilla et al, 2020) - Average Precision (AP) - La précision moyenne est une moyenne des précisions, calculée sur toutes les valeurs de rappel entre 0 et 1. Le calcul de la précision moyenne peut être interprété comme la recherche de l’aire en dessous de la courbe précision-rappel. Par l’interpolation de tous les points, la précision moyenne peut être interprétée comme étant l’aire en dessous de la courbe précision-rappel.

- Mean Average Precision (mAP) - La moyenne de la précision moyenne est une moyenne des précisions moyennes sur plusieurs seuils d’IoU. Par exemple, mAP@[0.5:0.05:0.95] correspond à la précision moyenne des valeurs de ratio d’IoU comprises entre 0,5 et 0,95, par incrément de 0,05, moyennées sur toutes les classes.

Bibliographie

Hui, Jonathan. "mAP (mean Average Precision) for Object Detection." Posted March 6, 2018 on Medium. https://medium.com/@jonathan_hui/map-mean-average-precision-for-object-detection-45c121a31173.

Padilla, Rafael, Sergio L. Netto, and Eduardo A. B. da Silva. "A Survey on Performance Metrics for Object-Detection Algorithms." 2020 International Conference on Systems, Signals and Image Processing (IWSSIP), 237-242 (2000).

"Detection Evaluation." COCO Common Objects in Context, accessed October 15, 2020, https://cocodataset.org/#detection-eval.

Vous avez un commentaire à formuler concernant cette rubrique ?