| Etiqueta | Explicación | Tipo de datos |

Tipo de predicción | Especifica el modo de operación que se utilizará. La herramienta puede ejecutarse para entrenar un modelo solo para evaluar rendimientos, predecir entidades o crear una superficie de predicción.

| String |

Entidades de entrenamiento de entrada | La clase de entidad que contiene el valor del parámetro Variable para predecir y, opcionalmente, las variables explicativas de entrenamiento provenientes de los campos. | Feature Layer |

Variable para predecir (Opcional) | La variable del valor del parámetro Entidades de entrenamiento de entrada que contiene los valores que se desean usar para entrenar el modelo. Este campo contiene valores (de entrenamiento) conocidos de la variable que se usará para predecir en ubicaciones desconocidas. | Field |

Tratar variable como variable de categorías (Opcional) | Especifica si el valor de Variable para predecir es una variable de categorías.

| Boolean |

Variables de entrenamiento explicativas (Opcional) | Una lista de campos que representan a las variables explicativas que ayudan a predecir el valor o la categoría del valor Variable para predecir. Active la casilla de verificación De categorías en el caso de las variables que representen clases o categorías (tales como cobertura de suelo, presencia o ausencia). | Value Table |

Entidades de distancia de entrenamiento explicativas (Opcional) | La capa de entidades que contiene las entidades de entrenamiento explicativas de la distancia. Se crearán automáticamente variables explicativas mediante el cálculo de una distancia desde las entidades proporcionadas a los valores de Entidades de entrenamiento de entrada. Se calcularán las distancias desde cada una de las entidades del valor Entidades de entrenamiento de entrada hasta los valores de Entidades de entrenamiento de distancia explicativa más cercanos. Si los valores de Entidades de distancia de entrenamiento explicativas de entrada son polígonos o líneas, los atributos de distancia se calcularán como la distancia entre los segmentos más cercanos del par de entidades. | Feature Layer |

Rásteres de entrenamiento explicativos (Opcional) | Las variables explicativas de entrenamiento extraídas de los rásteres. Las variables de entrenamiento explicativas se crearán automáticamente extrayendo valores de celda ráster. Para cada entidad del parámetro Entidades de entrenamiento de entrada, el valor de la celda ráster se extrae de esa ubicación exacta. Se usa remuestreo de ráster bilineal al extraer el valor de ráster en el caso de los rásteres continuos. La asignación de vecino más cercano se usa al extraer un valor de ráster desde rásteres de categorías. Active la casilla de verificación De categorías en el caso de los rásteres que representen clases o categorías tales como cobertura de suelo, presencia o ausencia. | Value Table |

Entidades de predicción de entrada (Opcional) | Una clase de entidad que representa las ubicaciones en las que se realizarán predicciones. Esta clase de entidad también debe contener las variables explicativas proporcionadas como campos que se correspondan con las utilizadas de los datos de entrenamiento. | Feature Layer |

Entidades predichas de salida (Opcional) | La clase de entidad de salida que contiene los resultados de predicción. | Feature Class |

Superficie de predicción de salida (Opcional) | El ráster de salida que contiene los resultados de predicción. El tamaño de celda predeterminado será el tamaño de celda máximo de las entradas ráster. Para definir otro tamaño de celda, utilice la configuración de entorno Tamaño de celda. | Raster Dataset |

Variables explicativas coincidentes (Opcional) | Una lista de los valores de Variables explicativas especificados del parámetro Entidades de entrenamiento de entrada de la derecha y sus campos correspondientes del parámetro Entidades de predicción de entrada de la izquierda. | Value Table |

Entidades de distancia coincidentes (Opcional) | Una lista de los valores de Entidades de distancia explicativas especificados para el parámetro Entidades de entrenamiento de entrada de la derecha y sus conjuntos de entidades correspondientes del parámetro Entidades de predicción de entrada de la izquierda. Puede proporcionar valores de Entidades de predicción de entrada más adecuados para el parámetro Entidades de distancia explicativas si aquellos que se utilizan para el entrenamiento se encuentran en un área de estudio o periodo de tiempo distintos. | Value Table |

Rásteres explicativos coincidentes (Opcional) | Una lista de los valores de Rásteres explicativos especificados para el parámetro Entidades de entrenamiento de entrada de la derecha y sus rásteres correspondientes del parámetro Entidades de predicción de entrada o el parámetro Superficie de predicción que se crearán a la izquierda. Puede proporcionar valores de Rásteres explicativos más adecuados para el parámetro Entidades de predicción de entrada si aquellos que se utilizan para el entrenamiento se encuentran en un área de estudio o periodo de tiempo distintos. | Value Table |

Entidades de entrenamiento de salida (Opcional) | Las variables explicativas utilizadas para el entrenamiento (incluidos los valores de ráster y los cálculos de distancia muestreados), así como el campo Variable para predecir observado y las predicciones de acompañamiento que se utilizarán para evaluar en mayor profundidad el rendimiento del modelo entrenado. | Feature Class |

Tabla de importancia variable de salida (Opcional) | La tabla que contendrá información que describe la importancia de cada variable explicativa utilizada en el modelo. Las variables explicativas contienen campos, entidades de distancia y rásteres utilizados para crear el modelo. Si el valor del parámetro Tipo de modelo es Incremento de gradiente, la importancia se mide por la ganancia, el peso y la cobertura, y la tabla contendrá estos campos. El resultado contiene un diagrama de barras, si el valor del parámetro Número de ciclos de validación es uno, o un diagrama de caja, si el valor es mayor que uno, de la importancia de las variables explicativas. | Table |

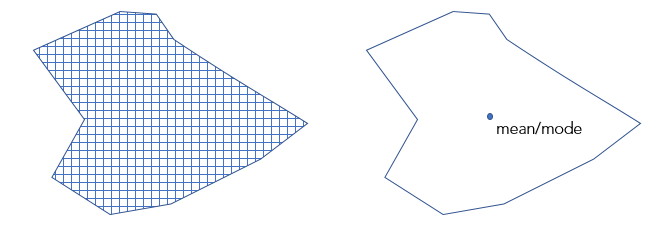

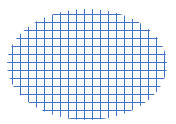

Convertir polígonos a resolución ráster para entrenamiento (Opcional) | Especifica la forma de tratar a los polígonos al entrenar el modelo si los valores de Entidades de entrenamiento de entrada son polígonos con un valor de categorías para Variable para predecir y si solo se han proporcionado valores de Rásteres de entrenamiento explicativos.

| Boolean |

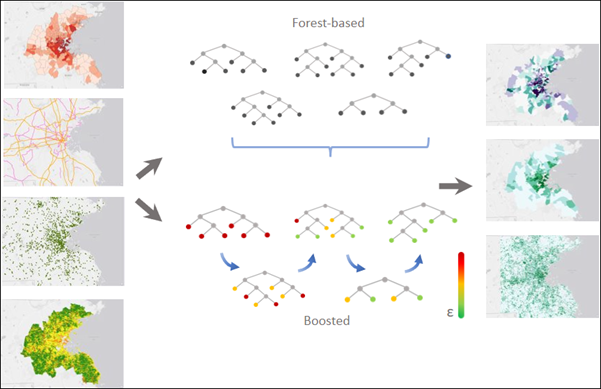

Número de árboles (Opcional) | El número de árboles que se crearán en los modelos basados en bosque y con incremento de gradiente. El valor predeterminado es 100. Si el valor del parámetro Tipo de modelo es Basado en bosque, un mayor número de árboles dará lugar generalmente a predicciones del modelo más precisas; sin embargo, el modelo tardará más en calcularse. Si el valor del parámetro Tipo de modelo es Incremento de gradiente, un mayor número de árboles puede dar lugar a predicciones más precisas del modelo; sin embargo, también pueden llevar a un exceso de ajuste de los datos de entrenamiento. Para evitar el exceso de ajuste de los datos, proporcione valores para los parámetros Profundidad máxima de árbol, Regularización L2 (Lambda), Reducción de pérdida mínima para divisiones (Gamma) y Tasa de aprendizaje (Eta). | Long |

Tamaño mínimo de hoja (Opcional) | El número mínimo de observaciones requeridas para conservar una hoja (es decir, el nodo terminal de un árbol que no tiene más divisiones). El mínimo predeterminado para regresión es 5 y el mínimo predeterminado para clasificación es 1. En el caso de datos muy grandes, si aumenta estos números se reducirá el tiempo de ejecución de la herramienta. | Long |

Profundidad máxima de árbol (Opcional) | El número máximo de divisiones que se realizarán en un árbol. Si se utiliza una profundidad máxima grande, se podrán crear más divisiones, lo cual puede aumentar las probabilidades de exceso de ajuste en el modelo. Si el valor del parámetro Tipo de modelo es Basado en bosque, por defecto está basado en datos y depende del número de árboles creados y del número de variables incluidas. Si el valor del parámetro Tipo de modelo es Incremento de gradiente, el valor predeterminado es 6. | Long |

Datos disponibles por árbol (%) (Opcional) | El porcentaje de valores de Entidades de entrenamiento de entrada que se utilizarán para cada árbol de decisión. El valor predeterminado es del 100 por cien de los datos. Las muestras de cada árbol se toman aleatoriamente a partir de dos tercios de los datos especificados. Cada árbol de decisión del bosque se crea con una muestra o un subconjunto aleatorios (aproximadamente dos tercios) de los datos de entrenamiento disponibles. El uso de un porcentaje menor de los datos de entrada para cada árbol de decisión disminuye el tiempo de ejecución de la herramienta en el caso de datasets muy grandes. | Long |

Número de variables muestreadas aleatoriamente (Opcional) | El número de variables explicativas que se utilizarán para crear cada árbol de decisión. Cada árbol de decisión en los modelos basados en bosque y con incremento de gradiente se crea utilizando un subconjunto aleatorio de las variables explicativas especificadas. Al aumentar el número de variables utilizadas en cada árbol de decisión, aumentarán también las probabilidades de exceso de ajuste en el modelo, especialmente si existen una o varias variables dominantes. La forma predeterminada es utilizar la raíz cuadrada del número total de variables explicativas (campos, distancias y rásteres combinados) si el valor Variable para predecir es de categorías o dividir el número total de variables explicativas (campos, distancias y rásteres combinados) por 3 si el valor Variable para predecir es numérico. | Long |

Datos de entrenamiento excluidos para la validación (%) (Opcional) | El porcentaje (entre el 10 y el 50 por ciento) de los valores de Entidades de entrenamiento de entrada que se reservarán como el dataset de prueba para la validación. El modelo se entrenará sin este subconjunto aleatorio de datos, y los valores predichos por el modelo para esas entidades se compararán con los valores observados. El valor predeterminado es del 10 por ciento. | Double |

Tabla de rendimiento de clasificación de salida (matriz de confusión) (Opcional) | Una matriz de confusión que resume el rendimiento del modelo creado sobre los datos de validación. La matriz compara las categorías predichas por el modelo para los datos de validación con las categorías reales. Esta tabla puede utilizarse para calcular diagnósticos adicionales que no se incluyen en los mensajes de salida. Este parámetro está disponible cuando el valor Variable para predecir es categórico y el parámetro Tratar variable como variable de categorías está marcado. | Table |

Tabla de validación de salida (Opcional) | Una tabla que contiene el R2 de cada modelo si el valor de Variable para predecir no es de categorías, o bien la precisión de cada modelo si el valor es de categorías. Esta tabla contiene un gráfico de barras de la distribución de las precisiones o de los valores R2. Esta distribución se puede usar para evaluar la estabilidad del modelo. Este parámetro está disponible cuando el valor de Número de ciclos de validación es superior a 2. | Table |

Compensar categorías dispersas (Opcional) | Especifica si cada categoría del dataset de entrenamiento, independientemente de su frecuencia, se representará en cada árbol. Este parámetro solo está disponible si el valor del parámetro Tipo de modelo es Basado en bosque.

| Boolean |

Número de ciclos de validación (Opcional) | El número de iteraciones de la herramienta. La distribución de los valores R2 o las precisiones de todos los modelos pueden visualizarse utilizando el parámetro Tabla de validación de salida. Si el valor del parámetro Tipo de predicción es Predecir a ráster o Predecir a entidades, se utilizará el modelo que haya producido el valor R2 o la precisión más altos para realizar las predicciones. | Long |

Calcular incertidumbre (Opcional) | Especifica si la incertidumbre de predicción se calculará al entrenar, predecir a entidades o predecir a ráster. Este parámetro solo está disponible si el valor del parámetro Tipo de modelo es Basado en bosque.

| Boolean |

Archivo de modelo entrenado de salida (Opcional) | Un archivo de modelo de salida que guardará el modelo entrenado, que se puede utilizar más tarde para la predicción. | File |

Tipo de modelo (Opcional) | Especifica el método que se utilizará para crear el modelo.

| String |

Regularización L2 (Lambda) (Opcional) | Un término de regularización que reduce la sensibilidad del modelo a las entidades individuales. Si se aumenta este valor, el modelo es más conservador y evita el exceso de ajuste de los datos de entrenamiento. Si el valor es 0, el modelo se convierte en un incremento de gradiente tradicional. El valor predeterminado es 1. Este parámetro solo está disponible si el valor del parámetro Tipo de modelo es Incremento de gradiente. | Double |

Reducción de pérdida mínima para divisiones (Gamma) (Opcional) | Un umbral para la reducción de pérdida mínima necesaria para dividir los árboles. Las divisiones potenciales se evalúan para su reducción de pérdida. Si la división candidata tiene una reducción de pérdida superior a este valor umbral, se producirá la partición. Los valores de umbral más altos evitan el exceso de ajuste y dan lugar a modelos más conservadores con menos particiones. El valor predeterminado es 0. Este parámetro solo está disponible si el valor del parámetro Tipo de modelo es Incremento de gradiente. | Double |

Tasa de aprendizaje (Eta) (Opcional) | Un valor que reduce la contribución de cada árbol a la predicción final. El valor debe ser mayor que 0 y menor o igual que 1. Una tasa de aprendizaje más baja evita el exceso de ajuste del modelo; sin embargo, puede requerir más tiempo de cómputo. El valor predeterminado es de 0,3. Este parámetro solo está disponible si el valor del parámetro Tipo de modelo es Incremento de gradiente. | Double |

Número máximo de bins para buscar divisiones (Opcional) | El número de bins en que se dividirán los datos de entrenamiento para buscar el mejor punto de división. El valor no puede ser 1. El valor predeterminado es 0, que corresponde a la utilización de un algoritmo codicioso. El algoritmo codicioso creará una división candidata en cada punto de datos. No se recomienda proporcionar un número demasiado reducido de bins para la búsqueda porque provocará un rendimiento deficiente de la predicción del modelo. Este parámetro solo está disponible si el valor del parámetro Tipo de modelo es Incremento de gradiente. | Long |

Optimizar parámetros (Opcional) | Especifica si se utilizará un método de optimización para encontrar el conjunto de hiperparámetros que logran un rendimiento óptimo del modelo.

| Boolean |

Método de optimización (Opcional) | Especifica el método de optimización que se utilizará para seleccionar y probar los puntos de búsqueda para encontrar el conjunto óptimo de hiperparámetros. Los puntos de búsqueda son combinaciones de hiperparámetros dentro del espacio de búsqueda especificado por el parámetro Ajuste de parámetros del modelo. Esta opción está disponible si el parámetro Parámetros de optimización está activado.

| String |

Optimizar objetivo (Objetivo) (Opcional) | Especifica la función objetivo o el valor que se minimizará o maximizará para encontrar el conjunto óptimo de hiperparámetros.

| String |

Número de ciclos para conjuntos de parámetros (Opcional) | El número de puntos de búsqueda dentro del espacio de búsqueda especificado por el parámetro Ajuste de parámetros del modelo que se probarán. Este parámetro está disponible si el valor de Método de optimización es Búsqueda aleatoria (Rápida) o Búsqueda aleatoria (Robusta). | Long |

Ajuste de parámetros del modelo (Opcional) | Una lista de hiperparámetros y sus espacios de búsqueda. Personalice el espacio de búsqueda de cada hiperparámetro proporcionando un límite inferior, un límite superior y un intervalo. El límite inferior y el límite superior especifican el rango de valores posibles para el hiperparámetro. A continuación, se indica el rango de valores válidos para cada hiperparámetro:

| Value Table |

Tabla de ajuste de los parámetros de salida (Opcional) | Una tabla que contiene los ajustes de los parámetros y los valores del objetivo para cada ensayo de optimización. El resultado contiene un gráfico de todas las pruebas y sus valores objetivo. Esta opción está disponible si la opción Optimizar parámetros está activada. | Table |

Salida derivada

| Etiqueta | Explicación | Tipo de datos |

| Capas ráster de incertidumbre de salida | Si el parámetro Calcular incertidumbre está activado, la herramienta calculará un intervalo de predicción del 90 por ciento sobre cada valor predicho del parámetro Variable para predecir. | Raster Layer |