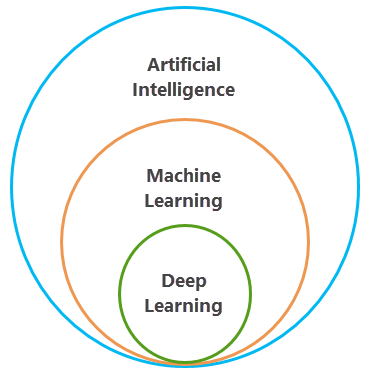

Las herramientas de aprendizaje automático han sido un componente principal del análisis espacial en SIG durante décadas. Ha sido capaz de utilizar el aprendizaje automático en ArcGIS para realizar la clasificación de imágenes, enriquecer datos con clustering y modelar relaciones espaciales. El aprendizaje automático es una rama de la inteligencia artificial en la que los datos estructurados se procesan con un algoritmo para resolver un problema. Los datos estructurados tradicionales requieren que una persona etiquete los datos, por ejemplo, imágenes de gatos y perros, de modo que las entidades específicas de cada tipo de animal se puedan entender en el algoritmo y utilizar para identificar a estos animales en otras imágenes.

El aprendizaje profundo es un subconjunto del aprendizaje automático que utiliza varias capas de algoritmos en forma de redes neurales. Los datos de entrada se analizan a través de distintas capas de la red, y cada capa define entidades y patrones específicos en los datos. Por ejemplo, si desea identificar entidades como edificios y carreteras, el modelo de aprendizaje profundo se entrenaría con imágenes de diferentes edificios y carreteras, procesando las imágenes a través de capas dentro de la red neuronal y, a continuación, buscando los identificadores necesarios para clasificar un edificio o carretera.

Esri ha desarrollado herramientas y flujos de trabajo para utilizar las últimas innovaciones en aprendizaje profundo a fin de responder a algunas de las preguntas más importantes en aplicaciones de SIG y teledetección. La visión informática o la capacidad de los equipos informáticos para comprender las imágenes o vídeos digitales es un área que ha pasado de los algoritmos de aprendizaje automático tradicionales a métodos de aprendizaje profundo. Antes de aplicar el aprendizaje profundo a las imágenes en AllSource, es importante comprender las distintas aplicaciones del aprendizaje profundo para la visión informática.

Aplicaciones de aprendizaje profundo para la visión informática

Hay muchas tareas de visión informática que se pueden llevar a cabo con redes neuronales de aprendizaje profundo. Esri ha desarrollado herramientas que permiten realizar la clasificación de imágenes, la detección de objetos, la segmentación semántica y la segmentación de instancias. Todas estas tareas de visión informática se describen a continuación, cada una con un ejemplo de teledetección y un ejemplo de visión informática más general.

Clasificación de imagen

La clasificación de imagen implica asignar una etiqueta o clase a una imagen digital. Por ejemplo, la imagen capturada con un dron que se muestra abajo a la izquierda se podría etiquetar como multitud y la foto digital de la derecha se podría etiquetar como gato. Este tipo de clasificación también se conoce como clasificación de objetos o reconocimiento de imágenes y se puede utilizar en SIG para categorizar entidades en una imagen.

Detección de objetos

La detección de objetos es el proceso de localizar entidades en una imagen. Por ejemplo, en la imagen de teledetección que se muestra a continuación, la red neuronal encontró la ubicación de un avión. En un caso de uso más general de visión informática, un modelo puede detectar la ubicación de diferentes animales. Este proceso generalmente implica dibujar un cuadro de delimitación alrededor de las entidades de interés. Se puede utilizar en SIG para localizar entidades específicas en imágenes de satélite, aéreas o tomadas por drones y para trazar dichas entidades en un mapa.

Segmentación semántica

La segmentación semántica se produce cuando cada píxel de una imagen se clasifica como perteneciente a una clase. Por ejemplo, en la imagen que se muestra abajo a la izquierda, los píxeles de carretera se clasifican por separado de los píxeles que no son de carretera. A la derecha, los píxeles que forman un felino en una foto se clasifican como felino, mientras que los otros píxeles de la imagen pertenecen a otras clases. En SIG, esto a menudo se denomina clasificación de píxeles, segmentación de imágenes o clasificación de imágenes. A menudo se utiliza para crear mapas de clasificación de uso del suelo.

Segmentación de instancias

La segmentación de instancias es un método de detección de objetos más preciso en el que se dibuja el límite de cada instancia de objeto. Por ejemplo, en la imagen de la izquierda que aparece a continuación, se detectan los tejados de las casas, incluido el contorno preciso de la forma del tejado. A la derecha, se detectan coches y puede ver la forma distinta de los coches. Este tipo de aplicación de aprendizaje profundo también se conoce como segmentación de objetos.

Segmentación panóptica

La segmentación panóptica combina la segmentación semántica y la segmentación de instancias. Por ejemplo, la imagen siguiente muestra que todos los píxeles están clasificados y cada objeto único, como cada automóvil, es su propio objeto único.

Traducción de imágenes

La traducción de imágenes es la tarea de traducir una imagen de una posible representación o estilo de la escena a otra, como la reducción de ruido o la superresolución. Por ejemplo, la imagen de la izquierda muestra la imagen original de baja resolución y la imagen de la derecha muestra el resultado de utilizar un modelo de alta resolución. Este tipo de aplicación de aprendizaje profundo también se conoce como traducción de imagen a imagen.

Detección de cambio

Las tareas de aprendizaje profundo de detección de cambios pueden detectar cambios en entidades de interés entre dos fechas y generar un mapa lógico de cambios. Por ejemplo, la imagen de la izquierda muestra un proyecto urbanístico de viviendas de hace cinco años, la imagen central muestra la misma urbanización hoy en día y la imagen de la derecha muestra el mapa de cambios lógicos en el que las viviendas nuevas están en blanco.