Sie können das Modell Text SAM im Werkzeug Objekte mit Deep Learning erkennen verwenden, das in der Toolbox "Image Analyst" in ArcGIS Pro verfügbar ist.

Führen Sie die folgenden Schritte aus, um das vortrainierte Modell "Text SAM" zu verwenden:

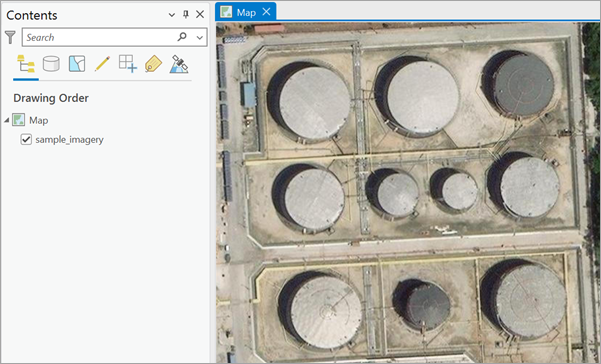

- Laden Sie das Modell herunter, und fügen Sie den Bilddaten-Layer in ArcGIS Pro hinzu.

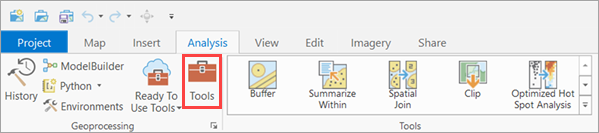

- Klicken Sie auf die Registerkarte Analyse, und navigieren Sie zu Werkzeuge.

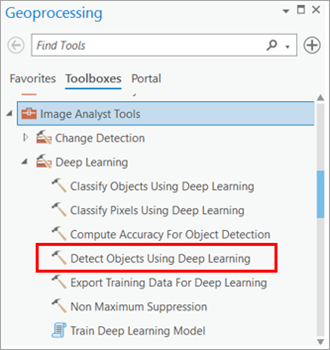

- Klicken Sie im Bereich Geoverarbeitung auf Toolboxes, und blenden Sie Image Analyst Tools ein. Wählen Sie unter Deep Learning das Werkzeug Objekte mit Deep Learning erkennen aus.

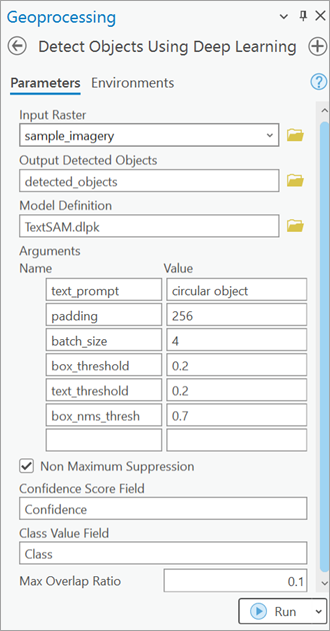

- Legen Sie die Variablen auf der Registerkarte Parameter wie folgt fest:

- Eingabe-Raster: Wählen Sie das Bild aus.

- Ausgabe der erkannten Objekte: Legen Sie die Ausgabe-Feature-Class fest, die die erkannten Objekte enthalten soll.

- Modelldefinition: Wählen Sie die .dlpk-Datei des vortrainierten Modells aus.

- Argumente (optional): Ändern Sie gegebenenfalls die Werte der Argumente.

- text_prompt: Text, der die zu erkennenden Objekte beschreibt. Die Eingabe können mehrere, durch Kommas getrennte Textvorgaben sein, die die Erkennung mehrerer Klassen ermöglichen.

- padding: Die Anzahl von Pixeln am Rahmen von Bildkacheln, aus denen Vorhersagen für benachbarte Kacheln verschmolzen werden. Erhöhen Sie den Wert, um die Ausgabe zu glätten und gleichzeitig Artefakte an den Kanten zu reduzieren. Der Maximalwert für Padding ist die Hälfte des Wertes für die Kachelgröße.

- batch_size: Die Anzahl der in den einzelnen Schritten der Modellinferenz verarbeiteten Kacheln. Dieser Wert hängt vom Speicher der Grafikkarte ab.

- box_threshold: Der Konfidenzwert, der für die Auswahl der Erkennungen verwendet wird, die in die Ergebnisse aufgenommen werden. Zulässige Werte liegen zwischen 0 und 1,0.

- text_threshold: Der Konfidenzwert, der zum Verknüpfen der erkannten Objekte mit der bereitgestellten Textvorgabe verwendet wird. Ein höherer Wert stellt eine stärkere Verknüpfung sicher, kann aber zu weniger Übereinstimmungen führen. Zulässige Werte liegen zwischen 0 und 1,0.

- box_nms_thresh: Der IoU-Grenzwert für Rahmen, der von der Funktion "Non Maximum Suppression" zum Filtern doppelter Masken verwendet wird.

- Non Maximum Suppression: Aktivieren Sie optional das Kontrollkästchen, um die überlappenden Features mit niedrigerem Konfidenzwert zu entfernen.

Wenn Sie das Kontrollkästchen aktiviert haben, führen Sie die folgenden Schritte aus:

- Feld für die Konfidenzpunktzahl: Verwenden Sie die Standardeinstellung.

- Klassenwertefeld: Verwenden Sie die Standardeinstellung.

- Max. Überlappungsrate: Legen Sie den Wert für die maximale Überlappungsrate auf 0,1 fest.

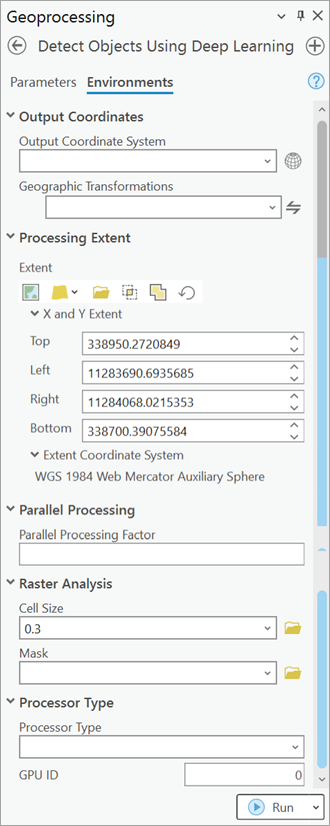

- Legen Sie die Variablen auf der Registerkarte Umgebungen wie folgt fest:

- Verarbeitungsausdehnung: Wählen Sie die Option Standard oder eine andere Option aus dem Dropdown-Menü aus.

- Zellengröße: Legen Sie einen geeigneten Wert fest.

Wählen Sie die Zellengröße in Meter so aus, dass die Sichtbarkeit der relevanten Objekte innerhalb der ausgewählten Ausdehnung maximiert wird. Sie könnten eine größere Zellengröße zum Erkennen größerer Objekte und eine kleiner Zellengröße zum Erkennen kleinerer Objekte verwenden. Beispiel: Legen Sie die Zellengröße für die Erkennung von Wolken auf 10 Meter und für die Erkennung von Autos auf 0,30 Meter (30 Zentimeter) fest. Weitere Informationen zur Zellengröße finden Sie in der bereitgestellten Ressource

- Prozessortyp: Wählen Sie nach Bedarf CPU oder GPU aus.

Wenn eine GPU verfügbar ist, wird empfohlen, die Option GPU auszuwählen und GPU-ID auf die zu verwendende GPU festzulegen.

- Klicken Sie auf Ausführen.

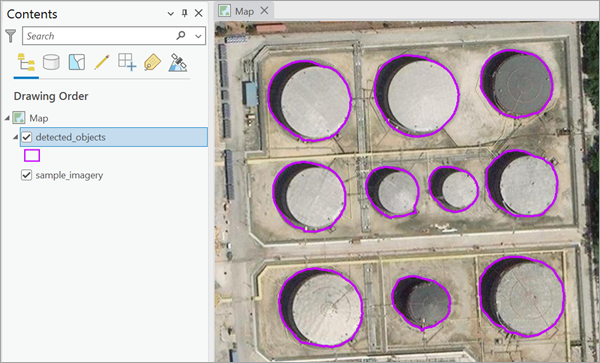

Wenn die Verarbeitung abgeschlossen ist, wird der Ausgabe-Layer der Karte hinzugefügt.