Mit der Image Analyst-Lizenz verfügbar.

Die Funktion "Full Motion Video" (FMV) in der Erweiterung ArcGIS Image Analyst stellt Funktionen für die Wiedergabe und räumliche Analyse von FMV-kompatiblen Videos bereit. FMV-kompatibel bezieht sich auf die Kombination eines Video-Streams und der zugehörigen Metadaten in einer Videodatei, sodass das Video einen räumlichen Bezug erhält. Die Sensorsysteme erfassen Kameraausrichtung, Plattformposition und -stellung sowie weitere Daten, die im Video-Stream codiert werden, sodass jedes Videobild mit Geopositionsinformationen verknüpft ist.

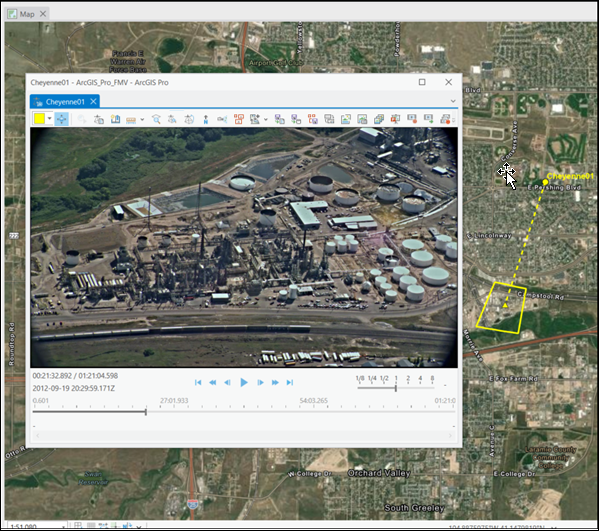

Dank dieser räumlich aktivierten Videodaten sowie der Rechenfunktionalität von ArcGIS AllSource können Sie das Video unter Berücksichtigung der Sensordynamik und des sichtbaren Bereichs anzeigen und bearbeiten, und Sie können diese Informationen in der Kartenansicht anzeigen. Außerdem können Sie Feature-Daten entweder in der Video- oder in der Kartenansicht analysieren und bearbeiten und haben damit die Möglichkeit der Telestration.

FMV verwendet die Metadaten, um Koordinaten nahtlos zwischen dem Videobildraum und dem Kartenraum zu konvertieren, ähnlich der Transformation von unbewegten Bildern durch das Bildkoordinatensystem in der Bildraumanalyse. Diese Konvertierung schafft die Grundlage für die Interpretation von Videodaten im Gesamtkontext aller anderen räumlichen Daten und Informationen in Ihrem GIS. Beispielsweise können Sie den Videobild-Footprint, den Bildmittelpunkt und die Position der Aufnahmeplattform während der Wiedergabe des Videos in der Kartenansicht anzeigen. Darüber hinaus können die GIS-Layer angezeigt werden, z. B. Gebäude mit IDs, GeoFences und andere relevante Informationen.

Sie können FMV-Daten unmittelbar nach der Erfassung entweder in Echtzeit oder forensisch analysieren. Sie eignen sich insbesondere für Situationsbewusstsein, da es sich häufig um die neuesten Bilddaten handelt, die für eine Position verfügbar sind. Wenn Sie beispielsweise nach einer Naturkatastrophe Schadensfeststellungen durchführen, können Sie FMV verwenden, um die neuesten, von einer Drohne gesammelten Videodaten zusammen mit den vorhandenen GIS-Daten-Layern zu analysieren. Da der Video-Footprint auf der Karte sichtbar ist, wissen Sie genau, welche Gebäude und Infrastruktur im Video zu sehen sind, und können ihren Zustand beurteilen, Boden-Features im Video und in der Karte markieren, ihre Positionen mit Lesezeichen versehen und Notizen mit detaillierten Beschreibungen hinzufügen. FMV ist so konzipiert, dass relevante Informationen schnell bewertet, analysiert und verbreitet werden können, um zeitnah Entscheidungshilfe zu bieten.

Weitere Informationen zu FMV finden Sie unter Häufig gestellte Fragen.

FMV-Features und Vorteile

FMV verwendet wichtige Metadaten und stellt visuelle und analytische Verarbeitungswerkzeuge sowie die folgenden ArcGIS AllSource-Funktionen bereit, um projekt- und unternehmenskritische Workflows zu unterstützen:

- FMV ist vollständig in ArcGIS AllSource integriert und nutzt die Systemarchitektur, die Datenmodelle, Werkzeuge und Funktionen sowie die Freigabe überall in ArcGIS.

- Sie können Live-Stream-Videos und archivierte Videos anzeigen und analysieren.

- Sie können den Videoplayer an eine beliebige Stelle auf dem Computerbildschirm verschieben und die Größe des Players anpassen oder ihn minimieren bzw. schließen.

- Der Videoplayer ist mit der Kartenanzeige verknüpft und ermöglicht daher Folgendes:

- Anzeigen des Video-Footprints, der Sensorposition und des sichtbaren Bereichs auf der Karte.

- Alle im Videoplayer erfassten Informationen werden auf die Karte projiziert und zusammen mit den vorhandenen GIS-Daten angezeigt.

- Aktualisieren der Karte, um auf das Videobild zu zoomen und Videos auf der Karte zu folgen.

- Sie können mehrere Videos gleichzeitig öffnen und wiedergeben. Jedes Video und die zugehörigen Informationen werden auf der Karte durch eine eindeutige Farbe identifiziert.

- Intuitive Wiedergabe-Steuerelemente, die Bild- und Videoclip-Erfassung sowie Analysewerkzeuge können verwendet werden.

- Metadaten können in Echtzeit angezeigt werden.

- Sie können Lesezeichen erstellen und verwalten.

- Positionen und relevante Phänomene können markiert werden.

- Die Anzeige wird durch die GPU beschleunigt.

Diese Funktionen bilden die Grundlage für Workflows, die räumlichen Kontext in den Videoanalyseprozess integrieren.

Verwendungszwecke für FMV

Eine primäre Verwendung von FMV besteht in der Unterstützung der Entscheidungsfindung in operativen Umgebungen. Informationen darüber, wer FMV einsetzt und wie die Daten erfasst und verwendet werden, bieten wichtigen Kontext für die Evaluierung der Funktionen von FMV.

Branchen, die FMV verwenden

FMV kann für die Überwachung abgelegener, unzugänglicher oder gefährlicher Orte verwendet werden. FMV wird u. a. von folgenden Organisationen bzw. Experten genutzt:

- Öffentliche Sicherheit und Katastrophenschutz

- Militär

- Ölunternehmen

- Kommunale und Regierungsbehörden

- Grenzschutz

- Dienstprogramme

- Fachleute für natürliche Ressourcen

Es gibt unter anderem die folgenden Anwendungsmöglichkeiten für FMV:

- Katastrophenschutz und öffentliche Sicherheit

- Situationsbewusstsein

- Schadensaufnahme

- Maßnahmenkoordination

- Eindämmung

- Sicherheitsüberwachung

- Asset-Management

- Korridor-Kartenerstellung, -Überwachung und -Management

- Versorgung, z. B. Elektrizität, Gas, Wasser oder Ähnliches

- Verkehrsnetz, z. B. Straßen, Brücken, Schienennetze, Autobahnen sowie Flughäfen, Seehäfen und Landesgrenzen

- Kommunikation, z. B. Mobilfunkmasten und Infrastruktur

- Hydrologie, einschließlich natürlicher und vom Menschen geschaffener Infrastruktur

- Ufer, z. B. Gewässerrand-Pufferstreifen, Lebensraum, Diversitätskartenerstellung und Verbindungen

- Militär

- Nachrichtendienst, Überwachung und Aufklärung

- Missionsunterstützung

- Spionageabwehr

- Überwachung der Infrastruktur

- Bestandsaufnahme

- Neubau

- Abgleich von Ausführung und Planung

- Compliance und Sicherheit

Erfassung von FMV-Daten

Die Full Motion Video-Anwendung in ArcGIS AllSource verwendet Daten, die aus einer Vielzahl von Fernerkundungsplattformen stammen. Videodaten und Metadaten werden gleichzeitig erfasst, und die Metadaten werden in der Videodatei codiert. Dies erfolgt entweder in Echtzeit auf der Sensorplattform (MISB-kompatibel) oder in einem späteren, auch als Multiplexing bezeichneten, Verarbeitungsschritt.

FMV-Daten können über unterschiedliche Sensorplattformen wie die folgenden erfasst werden:

- Drohnen (UAV, UAS und RPV)

- Starrflügel- und Hubschrauber-Befliegungsplattform

- Orbitale raumgestützte Sensoren

- Fahrzeugmontierte Kameras

- Mobile Handheld-Geräte und -Kameras

- Stationäre Geräte für Dauerüberwachung

Die unterstützten Videoformate, wie z. B. hochauflösende 4K-Formate, sind in der folgenden Tabelle aufgeführt:

| Beschreibung | Erweiterung |

|---|---|

MOV-Datei | .mov |

MPEG-2-Transportstrom | .ts |

MPEG-2-Programmstrom | .ps |

MPEG-Datei | .mpg |

MPEG-2-Datei | .mpg2 |

MPEG-2-Datei | .mp2 |

MPEG-Datei | .mpeg |

VLC (mpeg2) | .mpeg2 |

MPEG-4-Film | .mp4 |

MPEG-4-Datei | .mpg4 |

MPEG-DASH | .mpd |

H264-Videodatei¹ | .h264 |

H265-Videodatei¹ | .h265 |

VLC-Mediendatei (mpeg4) | .mpeg4 |

VLC-Mediendatei (vob) | .vob |

HLS (Adaptive Bitrate [ABR]) | .m3u8 |

¹ Erfordert Multiplexing |

Systemanforderungen für Full Motion Video

Nachfolgend werden die Mindestanforderungen sowie die empfohlenen und optimalen Anforderungen für Full Motion Video in ArcGIS AllSource beschrieben. Bei den Mindestanforderungen wird die Wiedergabe eines einzelnen Videos unterstützt. Bei den empfohlenen Anforderungen lassen sich Full Motion Video-Werkzeuge während der Wiedergabe eines einzelnen Videos verwenden. Die optimalen Anforderungen unterstützen die Verwendung von Full Motion Video-Werkzeugen während der Wiedergabe von mehreren Videos.

| Element | Unterstützt und empfohlen |

|---|---|

CPU | Minimum: 4 Kerne mit 2,6 GHz, simultanes Multithreading SMT- oder HT-CPUs (Simultanes Multithreading bzw. Hyperthreading) umfassen für gewöhnlich zwei Threads pro Kern. Eine Multithread-Doppelkern-CPU verfügt über vier Threads für die Verarbeitung. Eine Multithread-Sechskern-CPU verfügt demgegenüber über 12 Threads für die Verarbeitung. Empfohlen: 6 Kerne Optimal: 10 Kerne |

Funktionen von Full Motion Video

Full Motion Video unterstützt unterschiedliche operative Umgebungen von zeitkritischen Anwendungen wie Situationsbewusstsein und Notfallmaßnahmen unter Verwendung von Live-Streaming-Videos über die Analyse stündlich oder täglich archivierter Überwachungsvideos bis hin zur forensischen Analyse historischer Archivdaten. Jeder Anwendungstyp erfordert intuitive Visualisierungs- und Analysewerkzeuge, um schnell relevante Features oder Situationen zu identifizieren und aufzuzeichnen und die extrahierten Informationen an Entscheidungsträger und Projektbeteiligte weiterzugeben. Im Folgenden werden die Full Motion Video-Funktionen zur Unterstützung der Entscheidungsfindung nach ihren wesentlichen Funktionen unterteilt.

Kontextbezogene Video-Registerkarten

Wenn Sie ein Video in der Karte laden und dieses im Bereich Inhalt auswählen, werden die kontextbezogenen Registerkarten Standalone-Video und Player angezeigt.

Registerkarte "Standalone-Video"

Wenn ein Video in die Anzeige geladen wird, wird die Videodatei im Bereich Inhalt aufgeführt, und die Registerkarte Standalone-Video ist aktiviert. Mit den Werkzeugen auf der Registerkarte Standalone-Video können Sie Videodaten verwalten. Diese Registerkarte ist in die folgenden Gruppen unterteilt: Öffnen, Lesezeichen, Speichern und Verwalten.

Die Werkzeuge auf der Registerkarte Standalone-Video werden unter Registerkarte "Standalone-Video" beschrieben.

Registerkarte "Player"

Die Registerkarte Player ist kontextbezogen. Sie wird aktiviert, wenn Sie im Bereich Inhalt ein Video auswählen.

Die Registerkarte Player enthält Werkzeuge zum Navigieren im Video, zum Hinzufügen und Verwalten von Grafiken und zum Anzeigen von Video-Metadaten. Diese Werkzeuge stehen auch im Player zur Verfügung.

Zu den Werkzeugoperationen zählen das Zoomen der zugehörigen Kartenansicht, um das gesamte Videobild auf dem Boden anzuzeigen, das Anzeigen des Sensorpfades und des sichtbaren Bereichs des Videobildes auf dem Boden sowie das Zoomen und Schwenken der Karte, um dem Video auf dem Boden zu folgen. Diese Werkzeuge bieten einen geographischen Kontext, während Sie mit Videodaten arbeiten.

Videoplayer

Er verfügt über Standard-Steuerelemente wie Wiedergabe, schneller Vor- und Rücklauf, schrittweise vorwärts- und rückwärts, Sprung zum bzw. Ende des Videos Sie können auf ein Video zoomen und dieses durchlaufen, während es sich im Wiedergabe- oder im Pausenmodus befindet. Der Videoplayer kann für globale und lokale Szenen verwendet werden. Mit der Funktion Szenenkamera ausrichten wird die Szenenkamera auf die Perspektive des Videosensors ausgerichtet.

Zusätzliche Werkzeuge sind das Erfassen, Beschriften und Speichern von Video-Lesezeichen, das Erfassen einzelner Videobilder als Bilder und das Exportieren von Videoclips.

Lesezeichen

Das Erstellen von Video-Lesezeichen erfüllt eine wichtige Funktion bei der Aufzeichnung relevanter Phänomene und Features im Rahmen der Analyse eines Videos. Sie können Video-Lesezeichen in verschiedenen Abspielmodi eines Videos erfassen, z. B. bei Wiedergabe, Pause, Vor- und Rücklauf. Sie können Lesezeichen im Bereich Lesezeichen beschreiben; dieser wird angezeigt, wenn Sie ein Video-Lesezeichen erfassen. Lesezeichen werden im Bereich Lesezeichen erfasst und verwaltet, der auf der Registerkarte Karte in der Gruppe Navigieren in ArcGIS AllSource zur Verfügung steht.

Hinzufügen von Metadaten zu Videos

In FMV können Sie nur Videos verwenden, die essenzielle Metadaten enthalten. Üblicherweise erfassen hochwertige flugzeuggestützte Videodatenerfassungssysteme die erforderlichen Metadaten und codieren sie in Echtzeit in der Videodatei. Diese Daten können direkt in der Full Motion Video-Anwendung verwendet werden, entweder im Live-Streaming-Modus oder aus einer archivierten Datei.

Videoerfassungssysteme für Endverbraucher erzeugen oft separate Videodaten- und Metadatendateien, die zu einer einzelnen FMV-kompatiblen Videodatei kombiniert werden müssen. Dieser auch als Multiplexing bezeichnete Prozess wird in der Software durchgeführt. Full Motion Video enthält das Werkzeug Video-Multiplexer, das die richtigen Metadaten an der richtigen Position der Videodatei codiert, um eine einzelne FMV-kompatible Videodatei zu erzeugen. Jede Video- und Metadatendatei verwendet Zeitstempel, um die Codierung der richtigen Metadaten an der richtigen Position in der Videodatei zu synchronisieren.

Die Metadaten werden aus geeigneten Sensoren generiert, z. B. GPS für die X-, Y- und Z-Position, Höhenmesser, inertiale Messeinheiten (Inertial Measurement Unit, IMU) oder andere Datenquellen für die Kameraausrichtung. Die Metadatendatei muss im CSV-Format mit kommagetrennten Werten vorliegen.

FMV-Metadaten werden verwendet, um den Flugpfad des Videosensors, die Mitte des Videobildes und den Footprint der Videobilder auf dem Boden zu berechnen. Darüber hinaus unterstützt FMV die Motion Imagery Standards Board (MISB)-Metadaten-Spezifikationen. Alle bereitgestellten MISB-Parameter werden im endgültigen FMV-kompatiblen Video codiert.

Mehrere Full Motion Video-Parameter enthalten die Kartenkoordinaten der vier Ecken des auf den Boden projizierten Videobildes. Wenn die Kartenkoordinaten der vier Eckpunkte angegeben sind, dann werden diese verwendet. Andernfalls berechnet die Anwendung den Video-Footprint anhand einer Teilmenge der erforderlichen Parameter.

Um die relativen Eckpunkte des Videobild-Footprints zu berechnen und als Bildumriss auf der Karte anzuzeigen, werden die nachfolgend aufgelisteten zwölf essenziellen Metadatenfelder benötigt:

- Präzisionszeitstempel

- Breitengrad des Sensors

- Längengrad des Sensors

- Ellipsoid-Höhe des Sensors oder echte Höhe des Sensors

- Kurs der Plattform

- Neigungswinkel der Plattform

- Rollwinkel der Plattform

- Relativer Rollwinkel des Sensors

- Relativer Höhenwinkel des Sensors

- Relativer Azimutwinkel des Sensors

- Horizontaler sichtbarer Bereich des Sensors

- Vertikaler sichtbarer Bereich des Sensors

Wenn die Metadaten vollständig und genau sind, berechnet die Anwendung die Ecken des Videobildes und die Größe, Form und Position des Videobildumrisses, der dann auf einer Karte angezeigt werden kann. Diese zwölf Felder umfassen die minimalen Metadaten, die erforderlich sind, um die Transformation zwischen Video und Karte zu berechnen, den Video-Footprint auf der Karte anzuzeigen und andere Funktionen wie die Digitalisierung und Markierung im Video und auf der Karte zu ermöglichen.

Full Motion Video unterstützt auf Objektverfolgungsmethoden basierende VMTI-Daten (Video Moving Target Indicator) in bewegten Bilddaten. Wenn VMTI-Daten in einer von der verknüpften Videodatei getrennten Datei aufgezeichnet werden, können Sie sie mit dem Werkzeug Video-Multiplexer in der Videodatei codieren.

Die Leistung der Multiplexing-Videodatei hängt vom Typ und von der Qualität der in der Metadatendatei enthaltenen Daten sowie davon ab, wie genau die Videodaten und die Metadatendateien synchronisiert sind. Wenn die Metadaten nicht genau sind oder Abweichungen enthalten, werden diese Diskrepanzen im Video codiert und bei der Wiedergabe des Videos auf der Karte angezeigt. Wenn die Datei metadata.csv lediglich die Felder UNIX Time Stamp, Sensor Latitude und Sensor Longitude enthält, wird zwar die Position des Sensors auf der Karte angezeigt, nicht jedoch der Footprint der Videobilder. Außerdem werden einige Funktionen, z. B. die Digitalisierung von Features und die Messung von Entfernungen im Video, nicht unterstützt.

Sie können Metadaten in die Metadatenvorlage FMV_Multiplexer_Field_Mapping_Template.csv im Ordner C:\Program Files\ArcGIS\Pro\Resources\FullMotionVideo eingeben. Diese Vorlage enthält die zwölf essenziellen Metadatenfelder, die für die Berechnung des Videobild-Footprints erforderlich sind, sowie zusätzliche Felder, die in der MISB-Spezifikation enthalten sind. Wenn die Metadaten-Feldnamen nicht mit den für die Metadatenvorlage benötigten Feldnamen übereinstimmen, können diese mit den Metadaten-Feldnamen in der Vorlage FMV_Multiplexer_Field_Mapping_Template.csv abgeglichen werden.

Im Idealfall sind die Videodaten und die Metadaten zeitsynchron. Wenn der Zeitstempel, der das Video und die Metadaten verbindet, nicht genau synchronisiert ist, sind der Video-Footprint und die Sensorpositionen auf der Karte in der Ansicht im Videoplayer versetzt. Wenn die Zeitverschiebung beobachtbar und gleichmäßig ist, kann der Multiplexer die Zeitabläufe der Metadaten an die des Videos anpassen. Die Zeitverschiebungen werden durch das Erstellen und Eingeben einer optionalen .csv-Datei in das Werkzeug Video-Multiplexer angewendet, das die Position mit Versatz im Video sowie die zugehörige Zeitdiskrepanz identifiziert. Verwenden Sie die Vorlage FMV_Multiplexer_TimeShift_Template.csv im Ordner C:\Program Files\ArcGIS\Pro\Resources\FullMotionVideo, um die Versätze anzupassen. Die Vorlage enthält Spalten mit den Beschriftungen elapsed time, d. h. die Position im Video, an der die Zeitverschiebung auftritt, und time shift, die die Höhe des Zeitversatzes angibt. Wenn die Zeitverschiebung zwischen dem Video und den Metadaten nicht gleichmäßig ist, können Sie mehrere Videopositionen mit den zugehörigen Zeitverschiebungen in der Vorlage auflisten. Dadurch wird dem Multiplexer mitgeteilt, wo die entsprechenden Metadaten in Relation zum Zeitablauf des Videos platziert werden sollen.

Objektverfolgung

Full Motion Video unterstützt zwei Objektverfolgungsmethoden, Video Moving Target Indication (VMTI) und auf Deep Learning basierende Verfolgung. VMTI-Methoden verfolgen Objekte manuell oder automatisch und codieren die Position des Objekts innerhalb eines bestimmten Videobildes. Jedes Objekt verfügt über eine Kennung (ID) und ein umgebendes Rechteck. Beide sind mit dem Objekt verknüpft, das mit dem archivierten Video gespeichert wird. Wenn das Video wiedergegeben wird, werden die mit dem VMTI-Objekt verknüpften Informationen angezeigt. Für Full Motion Video müssen codierte Videometadaten den Standard "Video Moving Target Indicator and Track Metadata" (ST 0903) des Motion Imagery Standards Board (MISB) erfüllen.

Die auf Deep Learning basierende Objektverfolgungsfunktion stellt automatisierte und computergestützte Werkzeuge für die verschiedensten Situationen beim Identifizieren und Verfolgen von Objekten in Videobilddaten bereit. Objekterkennung, Extraktion und Abgleich werden durch Deep-Learning-Technologie unterstützt. Erstellen Sie ein Deep-Learning-Modell zum Identifizieren von bestimmten Objekten und Feature-Classes, und verwenden Sie die Palette an Werkzeugen zum Identifizieren, Auswählen und Verfolgen dieser relevanten Objekte. Sie können die Schwerpunkte des Identifizierungsrechtecks eines Objekts digitalisieren und als Punktklasse in der Geodatabase des Projekts speichern. Sie können die Objekte dann bei der Wiedergabe des archivierten Videos anzeigen.

Hinweis:

Sie müssen Pakete für das Deep-Learning-Framework installieren, um die Deep-Learning-basierte Objektverfolgung auszuführen. Weitere Informationen finden Sie in den Systemanforderungen.

Zusammenfassung

Die räumlich aktivierten Eigenschaften von Full Motion Video eignen sich für Echtzeitanalysen oder forensische Analysen und Situationsbewusstseins-Anwendungen. Die Fähigkeit, den Videobild-Footprint und den Flugpfad auf die Karte zu projizieren und darauf anzuzeigen, liefert wichtigen Kontext für das Video und ermöglicht die bidirektionale Erfassung von Features im Videoplayer und in der Karte.

Zusammen mit beschrifteten Video-Lesezeichen bieten diese Funktionen einem Analysten die Möglichkeit, Videobilder oder -segmente für weitere Analysen zu identifizieren und diese Informationen mit anderen Projektbeteiligten zu teilen. Indem Sie FMV-kompatible Videos mit kompletter GIS-Funktionalität integrieren, können Sie wichtige Kontextinformationen synthetisieren, um fundierte Entscheidungen in operativen Umgebungen zu unterstützen.